Cet article a été publié dans le cadre de la Blogathon sur la science des données

introduction

En tant que data scientist, le web scraping est l'une des compétences vitales que vous devez maîtriser, et vous devriez rechercher des données utiles, collecter et pré-traiter les données afin que vos résultats soient significatifs et précis.

Avant de plonger dans les outils qui pourraient aider dans les activités d'exploration de données, confirmons que cette activité est légale étant donné que le web scraping a été une zone légale grise. Le tribunal de l'EE. UU. Le grattage Web entièrement légalisé des données accessibles au public sur 2020. Cela signifie que si vous avez trouvé des informations en ligne (comme les articles du wiki), alors il est légal de gratter les données.

Même comme ça, Quand tu le fais, assurez-vous de:

- Ne pas réutiliser ou republier les données d'une manière qui viole le droit d'auteur.

- Que vous respectiez les conditions d'utilisation du portail Web que vous grattez.

- Que vous ayez un taux de suivi équitable.

- N'essayez pas d'extraire des parties privées du portail Web.

Tant qu'il ne viole pas les termes ci-dessus, votre activité de grattage Web sera du côté légal.

Je pense que certains d'entre vous ont peut-être utilisé BeautifulSoup et des demandes pour collecter les données et les pandas pour les analyser pour vos projets. Cet article vous donnera cinq outils de grattage Web qui n'incluent pas BeautifulSoup; est libre d'utilisation et collecte les données pour votre prochain projet.

Le créateur de Common Crawl a créé cet outil car il part du principe que tout le monde devrait avoir la possibilité d'explorer et d'analyser les données qui l'entourent et de découvrir des informations utiles.. Ils fournissent des données de haute qualité qui n'étaient ouvertes qu'aux grandes institutions et instituts de recherche à tous les esprits indiscrets sans frais pour encourager leurs croyances open source..

Vous pouvez utiliser cet outil sans vous soucier des frais ou de toute autre difficulté financière. Si vous êtes étudiant, un débutant plongeant dans la science des données ou simplement une personne passionnée qui aime explorer les connaissances et découvrir de nouvelles tendances, cet outil serait utile. Rendre les données brutes de pages Web et les extraits de mots disponibles sous forme d'ensembles de données ouverts. Il propose également des ressources pour les instructeurs qui enseignent l'analyse des données et la prise en charge des cas d'utilisation non basés sur le code..

Traverser site Web pour plus d'informations sur l'utilisation des ensembles de données et des alternatives pour l'extraction des données.

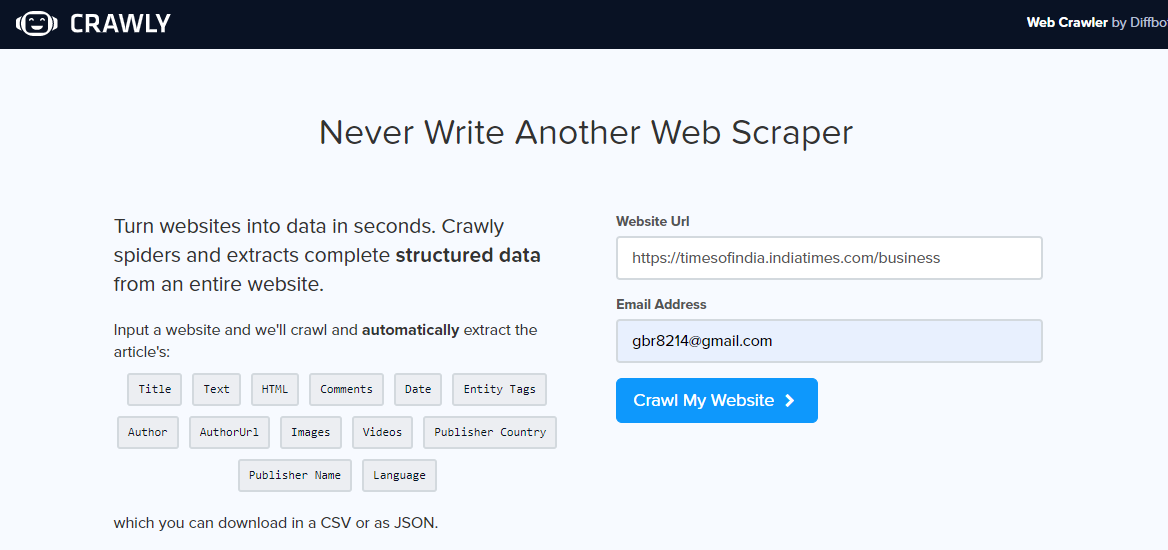

Crawly est une autre alternative, surtout si vous avez juste besoin d'extraire des données simples d'un portail Web ou si vous souhaitez extraire des données au format CSV afin de pouvoir les examiner sans écrire de code. L'utilisateur doit saisir une URL, une identification email pour envoyer les données extraites, le format des données requises (choisir entre CSV ou JSON) et prêt, les données extraites sont dans votre boîte de réception pour utilisation.

On peut utiliser des données JSON et les analyser à l'aide de Pandas et Matplotlib, ou tout autre langage de programmation. Si vous êtes un débutant en science des données et en scraping Web, pas un programmeur, c'est bien et a ses limites. Un ensemble limité de balises HTML, y compris le titre, peut être extrait, Auteur, URL de l'image et éditeur.

Une fois que vous avez ouvert le portail Web de suivi, entrez l'url à gratter, sélectionnez le format des données et votre identifiant e-mail pour recevoir les données. Vérifiez votre boîte de réception pour voir les données.

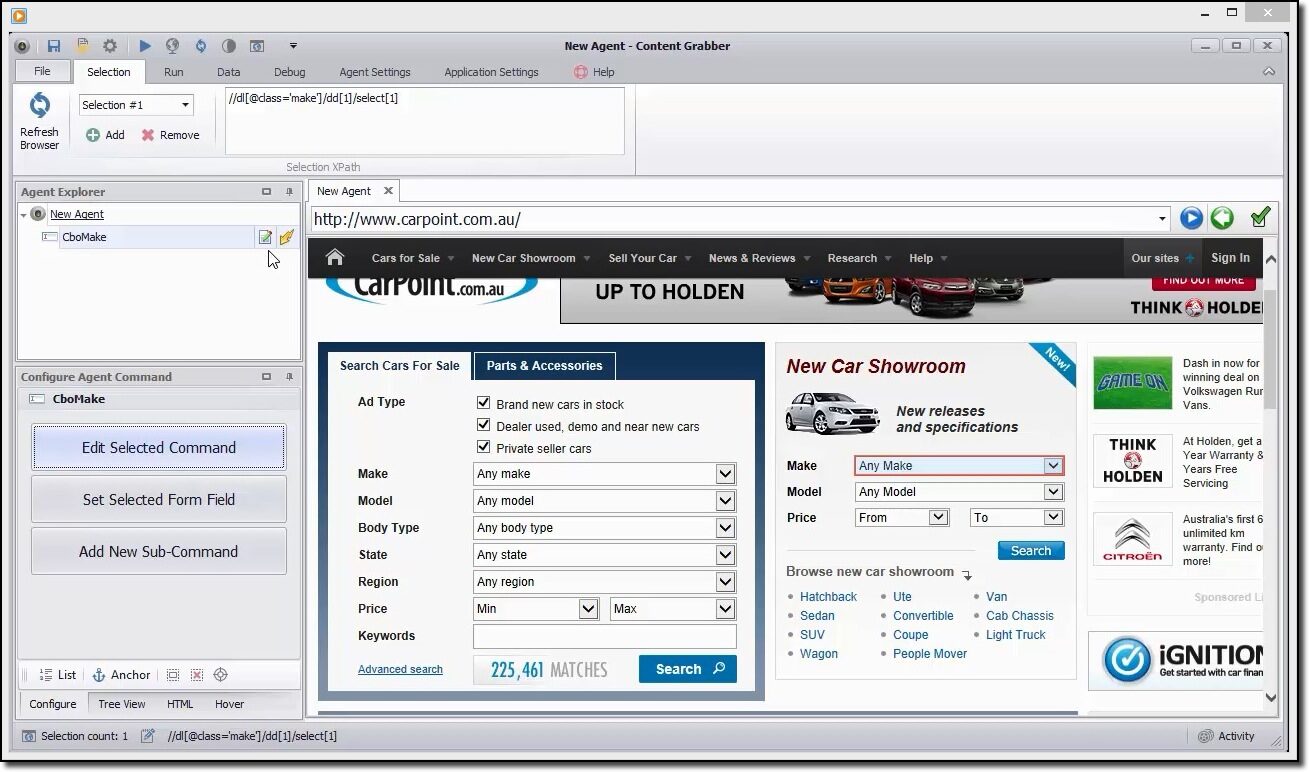

La capture de contenu est un outil flexible si vous aimez gratter une page Web et ne voulez pas spécifier d'autres paramètres, l'utilisateur peut le faire en utilisant son interface graphique simple. Même comme ça, offre l'option de contrôle total des paramètres d'extraction pour personnaliser.

L'utilisateur peut programmer automatiquement les informations de grattage à partir du Web, est l'un de ses avantages. Actuellement, nous savons tous que les pages Web sont mises à jour régulièrement, une extraction de contenu si fréquente serait utile.

Offre divers formats de données extraits comme CSV, JSON a SQL Server ou MySQL.

Un exemple rapide pour gratter les données

Vous pouvez utiliser cet outil pour naviguer visuellement sur le portail Web et cliquer sur les éléments de données dans l'ordre dans lequel vous souhaitez les collecter.. Il détectera automatiquement le type d'action correct et fournira des noms par défaut pour chaque commande lors de la création de l'agent en fonction des éléments de contenu spécifiés..

Cet outil est une collection de commandes qui sont exécutées dans l'ordre jusqu'à ce qu'elles soient terminées. L'ordre d'exécution est mis à jour dans le panneau Agent Explorer. Vous pouvez utiliser le panneau de commande de l'agent de configuration pour personnaliser la commande en fonction de vos besoins particuliers en matière de données.. Les utilisateurs peuvent également ajouter de nouvelles commandes.

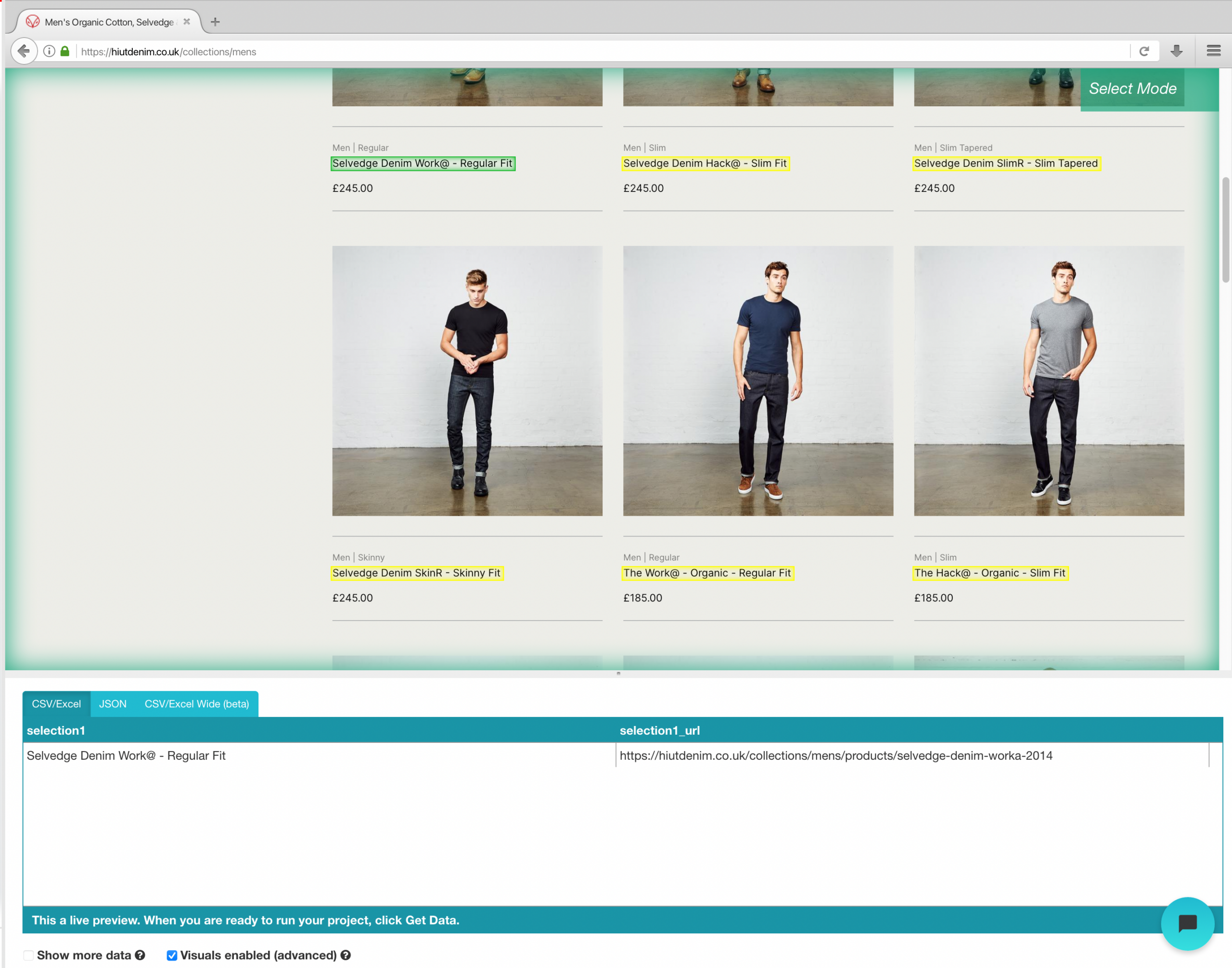

ParseHub est un puissant outil de grattage Web que tout le monde peut utiliser gratuitement. Offre une extraction de données sûre et précise en un seul clic. Les utilisateurs peuvent également déterminer des heures d'extraction pour maintenir la pertinence de leurs restes..

L'un de ses points forts est qu'il peut effacer sans problème même les pages Web les plus compliquées.. L'utilisateur peut spécifier des instructions telles que des formulaires de recherche, connectez-vous à des sites Web et cliquez sur des cartes ou des images pour une collecte de données ultérieure.

Les utilisateurs peuvent également entrer avec de nombreux liens et mots-clés, où ils peuvent extraire des informations pertinentes en quelques secondes. Pour terminer, vous pouvez utiliser l'API REST pour télécharger les données extraites pour analyse aux formats CSV ou JSON. Les utilisateurs peuvent également exporter les informations collectées sous forme de feuille Google ou Tableau..

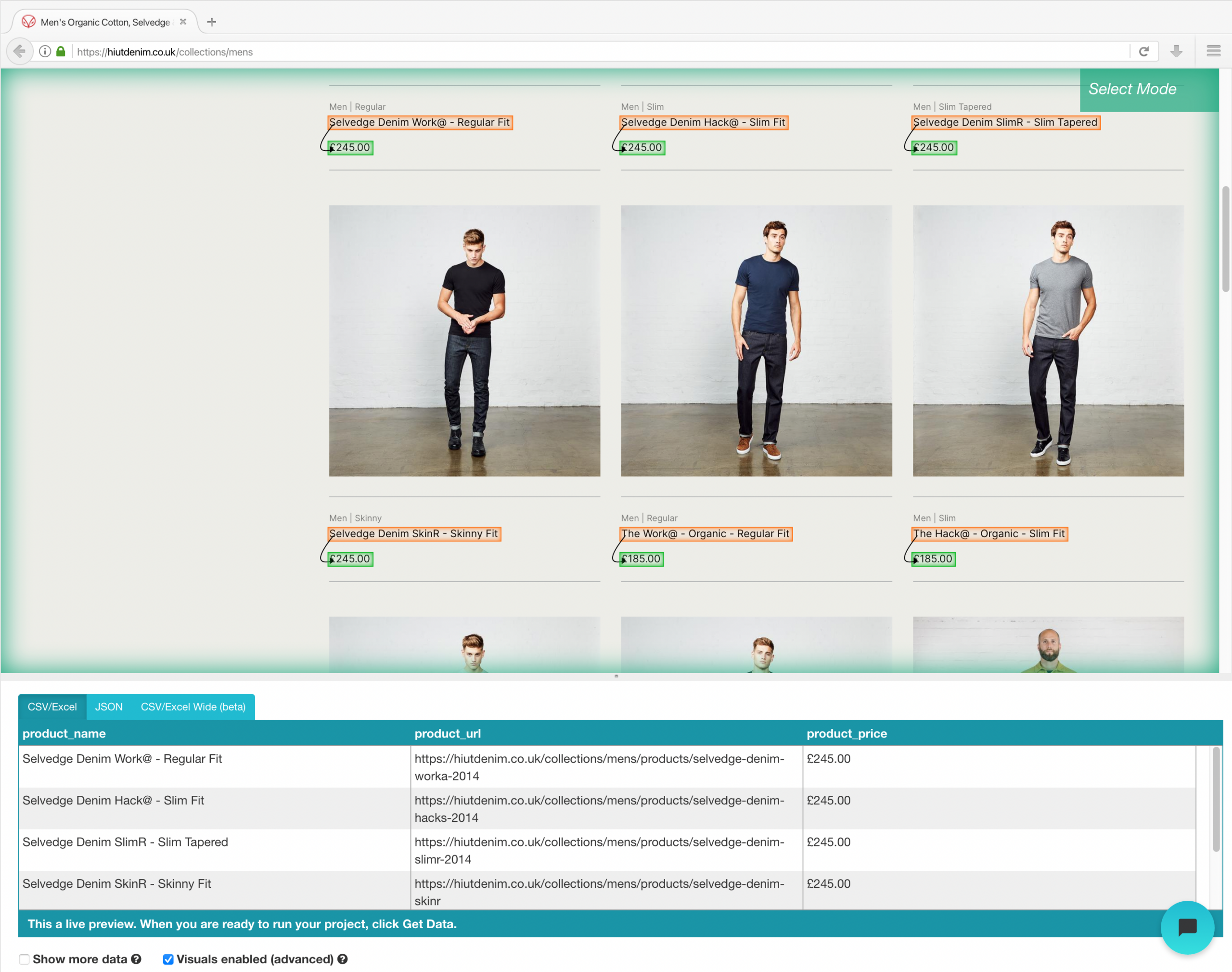

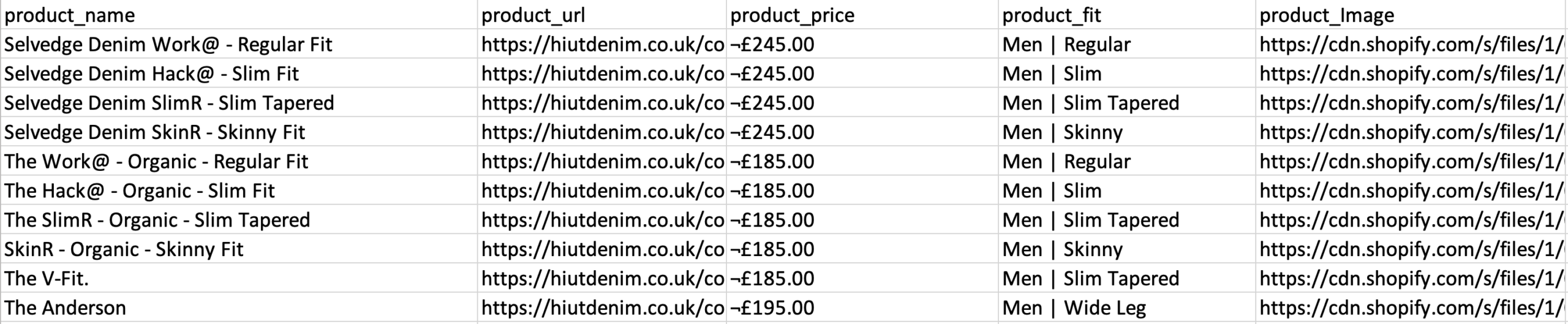

Exemple de portail Web de grattage de commerce électronique

Une fois l'installation terminée, ouvrir un nouveau projet sur ParseHub, utilisez l'URL de commerce électronique et la page s'affichera dans l'application.

- Cliquez sur le nom du produit du premier résultat sur la page une fois le site chargé. Lorsque vous sélectionnez le produit, devient vert pour indiquer qu'il a été choisi.

- Le jaune sera utilisé pour mettre en évidence le reste des noms de produits. Sélectionnez la deuxième option dans la liste. Le vert sera désormais utilisé pour mettre en évidence tous les objets.

- Changez le nom de votre choix en “produit” dans la barre latérale gauche. Vous pouvez maintenant voir le nom et l'URL du produit tirés par ParseHub.

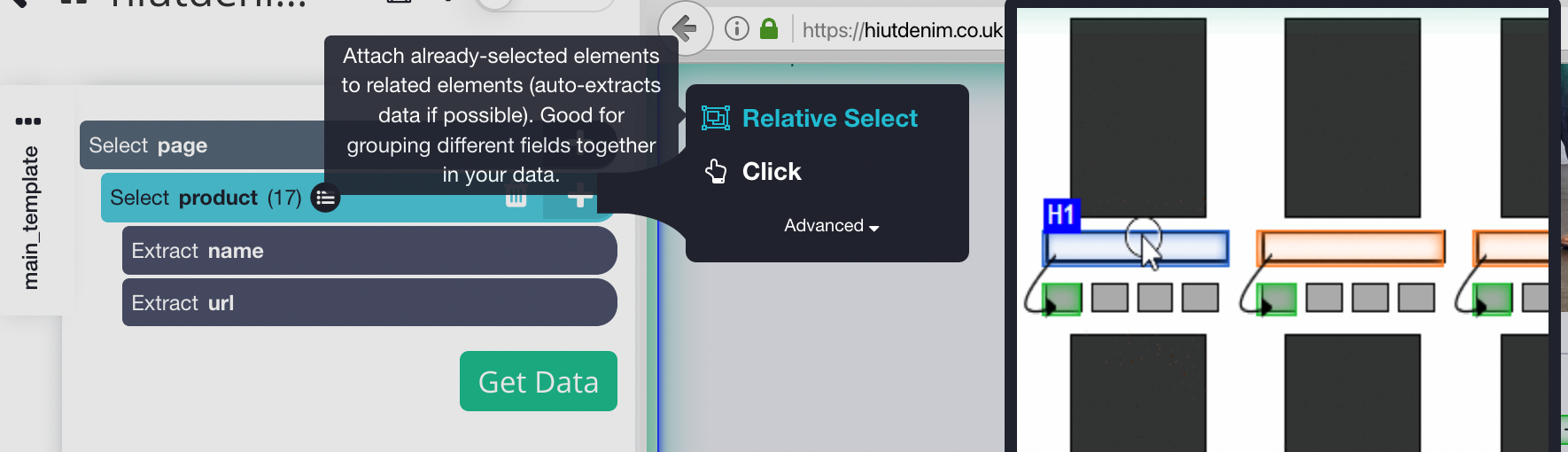

- Cliquez sur le signe PLUS (+) à côté de la sélection de produits dans la barre latérale gauche et sélectionnez la commande Sélection relative.

- Cliquez sur le premier nom du produit sur la page, suivi du prix du produit, à l'aide de la commande Sélection relative. Une flèche apparaîtra reliant les deux options. Cette étape doit être répétée plusieurs fois pour entraîner Parsehub à ce que vous souhaitez extraire.

- Répétez l'étape précédente pour extraire également le style d'ajustement et l'image du produit. Assurez-vous de renommer vos nouvelles options de manière appropriée.

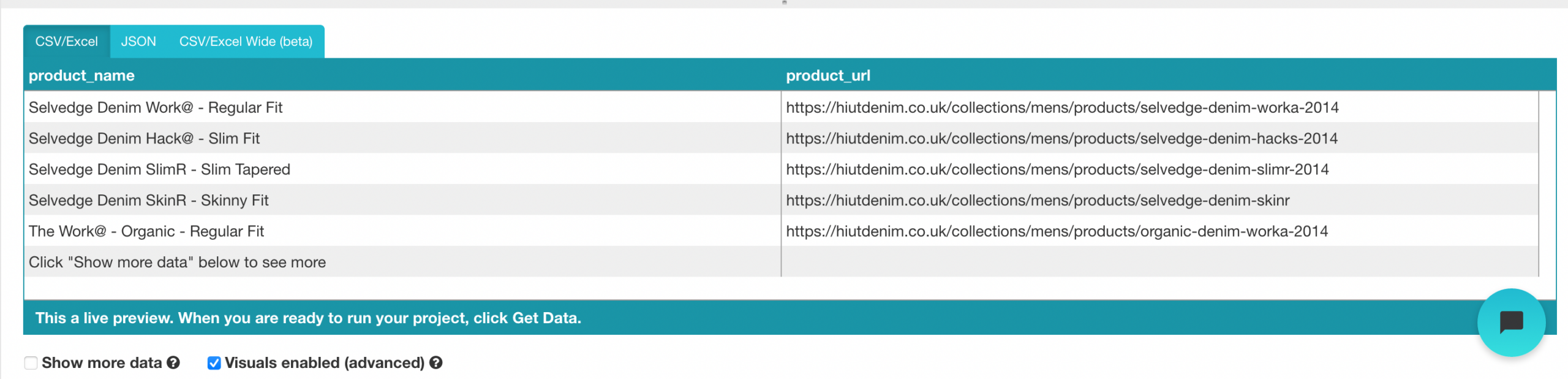

Exécution et export de votre projet

Maintenant que nous avons fini de configurer le projet, il est temps d'exécuter notre travail de scrape.

Pour exécuter votre grattage, cliquez sur le bouton Obtenir des données dans la barre latérale gauche, puis cliquez sur le bouton Exécuter. Pour les grands projets, nous vous suggérons d'effectuer un test pour vous assurer que vos données sont au bon format.

C'est le dernier outil de grattage sur la liste. Il dispose d'une API de grattage Web qui peut gérer même les pages Javascript les plus complexes et les convertir en HTML brut pour que les utilisateurs puissent les utiliser.. Il propose également une API spécifique pour scratcher des sites Web via la recherche Google..

Nous pouvons utiliser cet outil de l'une des trois manières suivantes:

- Web Scraping général, par exemple, extraire les avis des clients ou les cours des actions.

- Page de résultats des moteurs de recherche utilisée pour le suivi des mots clés ou le référencement.

- L'extraction d'informations de contact ou de données des réseaux sociaux inclut le Growth Hacking.

Cet outil offre un plan gratuit qui comprend 1000 crédits et forfaits payants pour une utilisation illimitée.

Tutoriel sur l'utilisation de l'API Scrapingbee

Inscrivez-vous pour un plan gratuit sur le portail Web ScrapingBee et vous obtiendrez 1000 requêtes API gratuites, ce qui devrait suffire pour apprendre et tester cette API.

Allez maintenant dans le panneau de configuration et copiez la clé API dont nous aurons besoin plus tard dans ce guide. ScrapingBee fournit désormais un support multilingue, vous permettant d'utiliser la clé API directement dans vos applications.

Étant donné que Scaping Bee prend en charge les API REST, convient à n'importe quel langage de programmation, y compris CURL, Python, NodeJS, Java, PHP et Go. Pour plus d'informations sur le grattage, nous utiliserons python et demanderons un framework, ainsi que BeautifulSoup. Installez-les en utilisant PIP comme suit:

# Pour installer la bibliothèque Python Requests: demandes d'installation de pip # Modules supplémentaires dont nous avions besoin: pip installer BeautifulSoup

Utilisez le code suivant pour démarrer l'API Web ScrapingBee. Nous effectuons un appel de requête avec les paramètres de l'URL et de la clé API, et l'API répondra avec le contenu HTML de l'url cible.

demandes d'importation

def get_data():

réponse = requêtes.get(

adresse url ="https://app.scrapingbee.com/api/v1/",

paramètres={

"clé API": "INSÉRER-VOTRE-CLÉ-API",

"Adresse URL": "https://exemple.com/", #site à gratter

},

)

imprimer('Code d'état HTTP: ', réponse.status_code)

imprimer('Corps de réponse HTTP: ', réponse.contenu)

obtenir_données()

Lors de l'ajout d'un code d'embellissement, nous pouvons rendre cette sortie plus lisible en utilisant BeautifulSoup.

Codage

De plus, vous pouvez utiliser urllib.parse pour crypter l'URL que vous souhaitez récupérer, comme il est montré dans ce qui suit:

import urllib.parse

encoded_url = urllib.parse.quote("URL à gratter")

conclusion

La collecte de données pour vos projets est l'étape la plus fastidieuse et la moins amusante. Cette tâche peut prendre beaucoup de temps, et si vous travaillez en entreprise ou en freelance, Je savais que le temps c'est de l'argent, et s'il y a une façon plus importante de faire une tâche, tu ferais mieux de l'utiliser. La bonne nouvelle est que le grattage Web ne doit pas être fastidieux, car l'utilisation du bon outil peut vous aider à gagner beaucoup de temps, argent et efforts. Ces outils peuvent être bénéfiques pour les analystes ou les personnes sans compétences en codage.. Avant de choisir un outil de grattage, il y a certains facteurs à considérer, telles que l'intégration d'API et l'extensibilité de grattage à grande échelle. Cet article vous a présenté quelques outils utiles pour différentes tâches de collecte de données., où vous pouvez sélectionner celui qui facilite la collecte de données.

j'espère que cet article sera utile. Merci.

Les médias présentés dans cet article ne sont pas la propriété de DataPeaker et sont utilisés à la discrétion de l'auteur.