Cet article a été publié dans le cadre du Blogathon sur la science des données.

Vue d'ensemble

- comprendre les GPU dans le deep learning.

- Commencer par les prérequis pour l'installation de TensorFlow -GPU.

- Installation et configuration de l'environnement GPU.

- Tester et vérifier l'installation du GPU

“Les graphismes ont fait

un grand virage vers l'apprentissage automatique, qui en soi consiste à comprendre

Les données”

_ Jefferson Han, Fondateur et scientifique en chef de Perceptive Pixel

La source: Google images

Comprendre les GPU dans le deep learning

Les processeurs peuvent récupérer des données plus rapidement, mais ils ne peuvent pas traiter plus de données en même temps, puisque le CPU doit faire de nombreuses itérations dans la mémoire principale pour effectuer une tâche simple. D'un autre côté, le GPU est livré avec sa propre mémoire VRAM (RAM vidéo) dédié, donc, fait moins d'appels à la mémoire principale, donc c'est rapide

Le processeur exécute les tâches de manière séquentielle et a moins de cœurs, mais les GPU sont livrés avec des centaines de cœurs plus petits qui fonctionnent en parallèle, ce qui fait du GPU une architecture hautement parallèle, qui améliore les performances.

Commencer par les prérequis pour l'installation de TensorFlow – GPU

Le GPU Tensorflow ne peut fonctionner que si vous disposez d'une carte graphique compatible CUDA. Toutes les nouvelles cartes graphiques NVidia des trois ou quatre dernières années ont activé CUDA.

Cependant, faisons une pause et vérifions si votre carte graphique est compatible CUDA, puisque "Faire des suppositions incorrectes cause de la douleur et de la souffrance à tous", dijo Jennifer jeune.

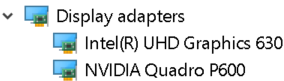

Pour vérifier les détails de la carte graphique. Ouvrez la fenêtre d'exécution à partir du menu Démarrer et exécutez Control / nom Microsoft.DeviceManager. La carte graphique apparaîtra sous Cartes graphiques

Chaque machine sera équipée de cartes graphiques intégrées placées sur la même puce que le processeur et s'appuyant sur la mémoire système pour gérer les graphiques., alors qu'une carte graphique discrète est une unité distincte du processeur et a des performances de traitement graphique élevées.

Les capacités GPU sont fournies par des cartes graphiques discrètes. Donc, assurez-vous que votre machine a à la fois une carte graphique intégrée et une carte graphique discrète installée.

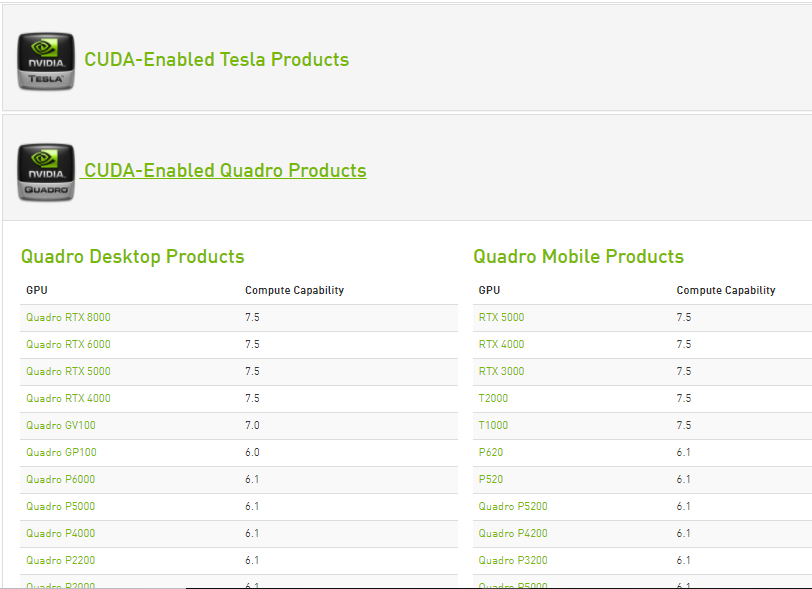

Les capacités de calcul de chaque carte graphique Nvidia compatible Cuda sont répertoriées sur le site Web de Nvidia.. Uniquement si une carte graphique discrète est disponible dans cette liste, peut prendre en charge le GPU TensorFlow.

La source: https://developer.nvidia.com/cuda-gpus

Une fois que l'on sait que la carte graphique discrète peut prendre en charge le GPU TensorFlow. Commencer l'installation

Pour s'assurer qu'aucun des paramètres ou paramètres NVidia ci-dessus n'affectera l'installation, désinstaller tous les logiciels et pilotes graphiques NVidia (étape facultative).

Installations préalables requises

Paso 1: Installation de Visual Studio 2017

Microsoft Visual Studio est un environnement de développement intégré Microsoft utilisé pour développer des programmes informatiques, ainsi que des sites Web, des applications Web, Webservices et applications mobiles.

La boîte à outils CUDA comprend des modèles de projet Visual Studio et NSight IDE (que vous pouvez utiliser à partir de Visual Studio). Nous devons installer la boîte à outils VC ++ 2017 (CUDA n'est pas encore compatible avec la dernière version de Visual Studio).

- Visual Studio peut être téléchargé sur le site officiel de Microsoft Visual Studio. Téléchargez le logiciel en sélectionnant la charge de travail 'Développement de bureau avec c++’ et l'installer.

- Boîte à outils Cuda pendant l'installation, installez les bibliothèques nécessaires puis vérifiez les versions de Visual Studio disponibles sur le système puis installez les intégrations Visual Studio. Donc, avoir un Visual Studio installé sur le système est une étape obligatoire à suivre.

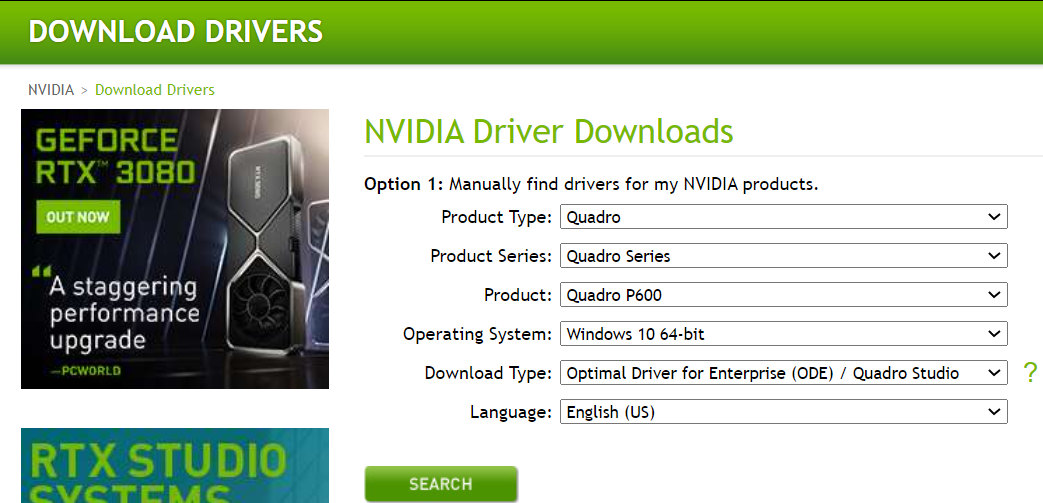

Paso 2: Téléchargez et installez le pilote NVIDIA

Pilote Nvidia est le pilote logiciel pour Nvidia GPU graphique installé sur le PC. C'est un programme utilisé pour communiquer du système d'exploitation Windows PC à l'appareil. Ce logiciel est nécessaire dans la plupart des cas pour que le périphérique matériel fonctionne correctement.

Pour décharger, Accédez à la page de téléchargement Nvidia.com et fournissez tous les détails de la carte graphique et du système dans les menus déroulants. Cliquez sur rechercher et nous vous fournirons le lien de téléchargement.

Installez les pilotes téléchargés depuis Nvidia

une fois installé, nous devrions obtenir un dossier NVidia GPU computing toolkit dans les fichiers programme du lecteur C qui contient le sous-dossier CUDA à l'intérieur.

Paso 3: Boîte à outils Cuda

La boîte à outils Nvidia CUDA fournit un environnement de développement pour la création d'applications accélérées par GPU hautes performances. Avec la boîte à outils CUDA, peut développer, optimisez et déployez vos applications sur des systèmes embarqués accélérés par GPU, postes de travail de bureau, centres de données d'entreprise, plateformes basées sur le cloud et supercalculateurs HPC. La boîte à outils comprend des bibliothèques accélérées par GPU, outils de débogage et d'optimisation, un compilateur C / C ++ et une bibliothèque d'exécution pour construire et déployer votre application sur toutes les architectures majeures, y compris x86, Arm y POWER.

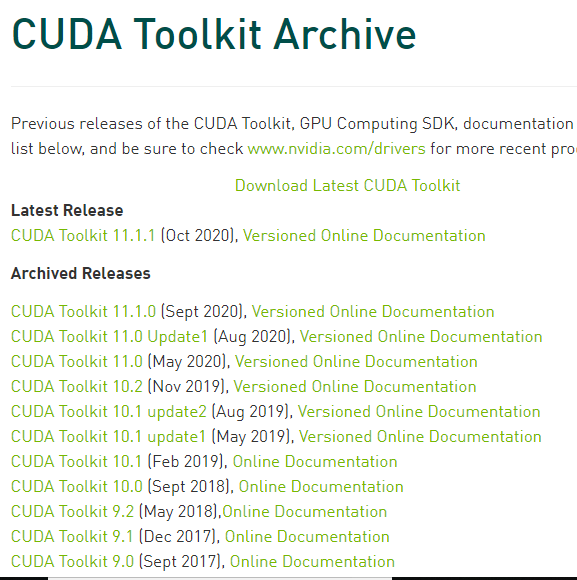

Il existe plusieurs versions de CUDA compatibles avec Tensorflow. Nous pouvons trouver la version actuelle de Cuda compatible avec TensorFlow, sur la page Web d'assistance du GPU TensorFlow.

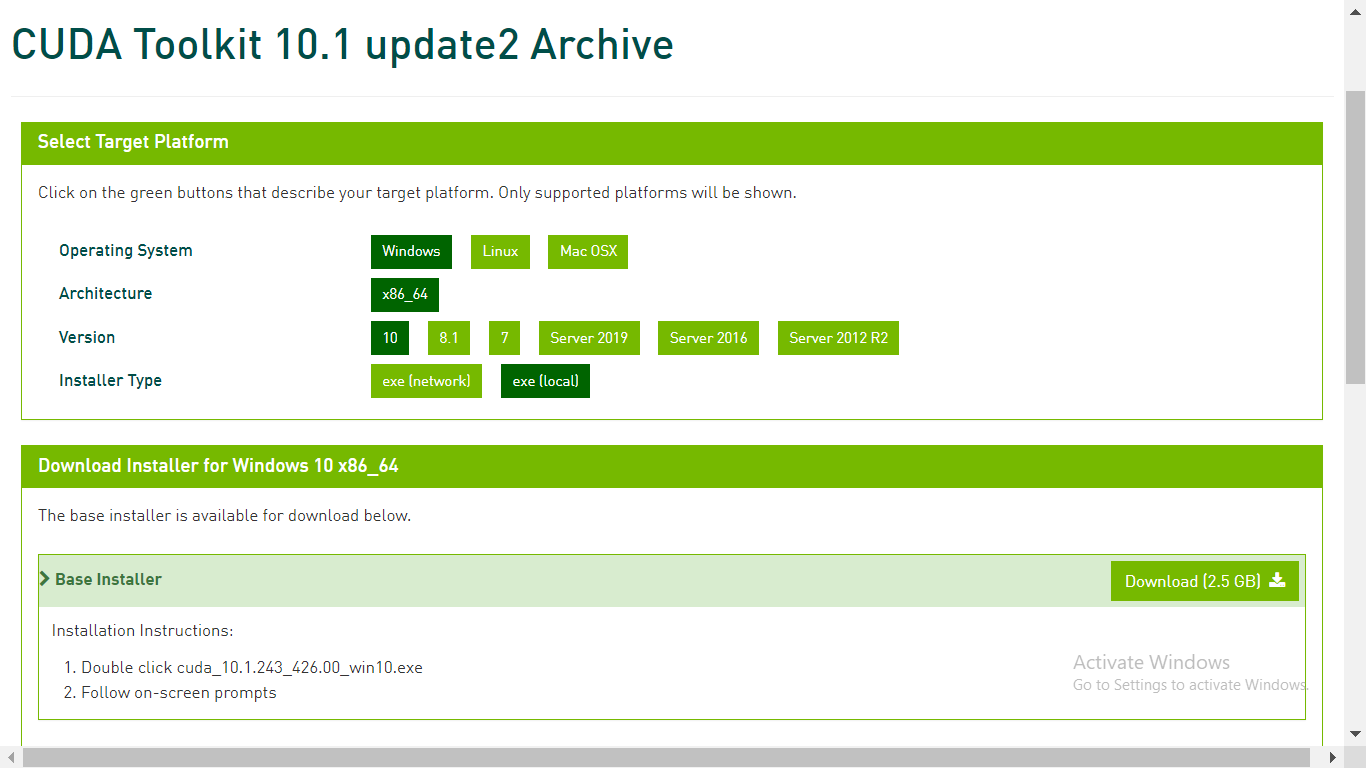

Dans le fichier de la boîte à outils CUDA sur developer.nvidia.com, télécharger la boîte à outils CUDA requise

Paso 4: Télécharger cuDNN

cuDNN est une bibliothèque avec un ensemble de primitives de bas niveau optimisées pour augmenter la vitesse de traitement des réseaux de neurones profonds (DNN) sur les GPU compatibles CUDA.

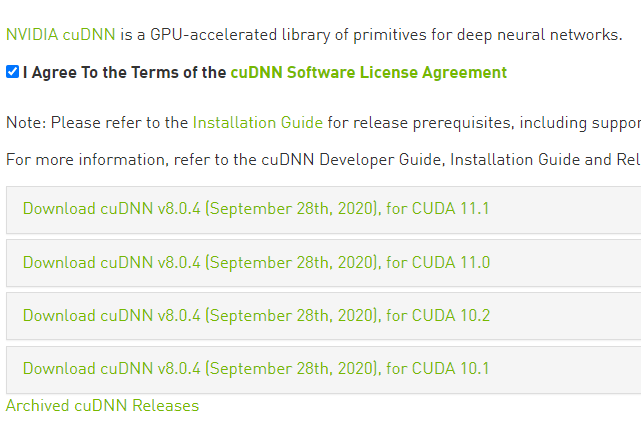

Accédez à la page Web de téléchargement de cuDNN sur developer.nvidia.com et téléchargez la version de cuDNN compatible avec la version de CUDA.

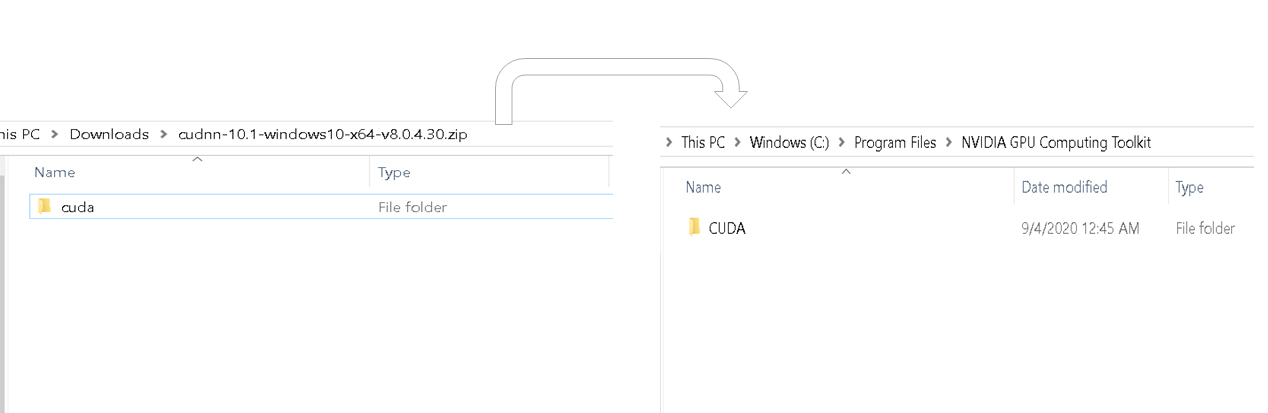

Une fois le téléchargement terminé, extraire le dossier téléchargé. Le dossier téléchargé doit contenir le dossier CUDA et ce dossier CUDA doit correspondre au contenu du dossier CUDA dans le dossier NVidia GPU Calculation Toolkit Program Files. Veuillez vous référer à l'image ci-dessous.

Copiez cudnn64_88.dll à partir du bac du dernier dossier extrait et collez-le dans le dossier bin similaire à l'intérieur du dossier Cuda du Nvidia GPU Computing Toolkit.

Copiez le fichier cudnn.h à partir du sous-dossier include du dernier dossier extrait et collez-le dans le dossier bin similaire dans le dossier Cuda de la boîte à outils de calcul GPU Nvidia.

Copiez le fichier cudnn.lib de lib> Sous-dossier du dossier X64 du dernier dossier extrait et collez-le dans le dossier bin similaire à l'intérieur du dossier Cuda du Nvidia GPU Computing Toolkit.

Nous avons maintenant terminé le téléchargement et l'installation de Cuda pour GPU. Mettons en place l'environnement.

Installation et configuration de l'environnement GPU

Anaconda est une distribution Python qui permet de configurer un environnement virtuel. En supposant qu'anaconda est déjà installé, commençons par créer un environnement virtuel.

Paso 1: Crémangé une variable d'environnement

Créez un environnement virtuel à partir de l'invite de commande à l'aide de la commande – conda créer -n [env_name] python = [version_python]

Tensor Flow ne prend en charge que certaines versions de Python. Choisissez une version de Python qui prend en charge Tensor lors de la création d'un environnement.

Ensuite, activer l'environnement virtuel à l'aide de la commande – Activer [env_name].

Dans l'environnement virtuel créé, installer la dernière version du GPU tensor flow à l'aide de la commande – pip installer – ignorer-installé – mettre à niveau TensorFlow-GPU

Une fois que nous avons terminé avec l'installation du GPU Tensor Flow, vérifiez si votre machine a des packages python de base comme les pandas, numpy, jupyter y dur. s'ils n'existent pas, les installer.

Installer ipykernel via la commande – pip installer ipykernel

Définissons le nom d'affichage et lions le noyau à la variable d'environnement virtuel à l'aide de la commande – python –m ipykernel install –utilisateur –nom [env_name] –Afficher le nom "n'importe quel nom".

Paso 2: définir le noyau python sur jupyter.

Ouvrez le bloc-notes jupyter et dans la barre de menus, cliquez sur le noyau et changez le noyau en variable d'environnement que nous venons de définir

Tester et vérifier l'installation du GPU.

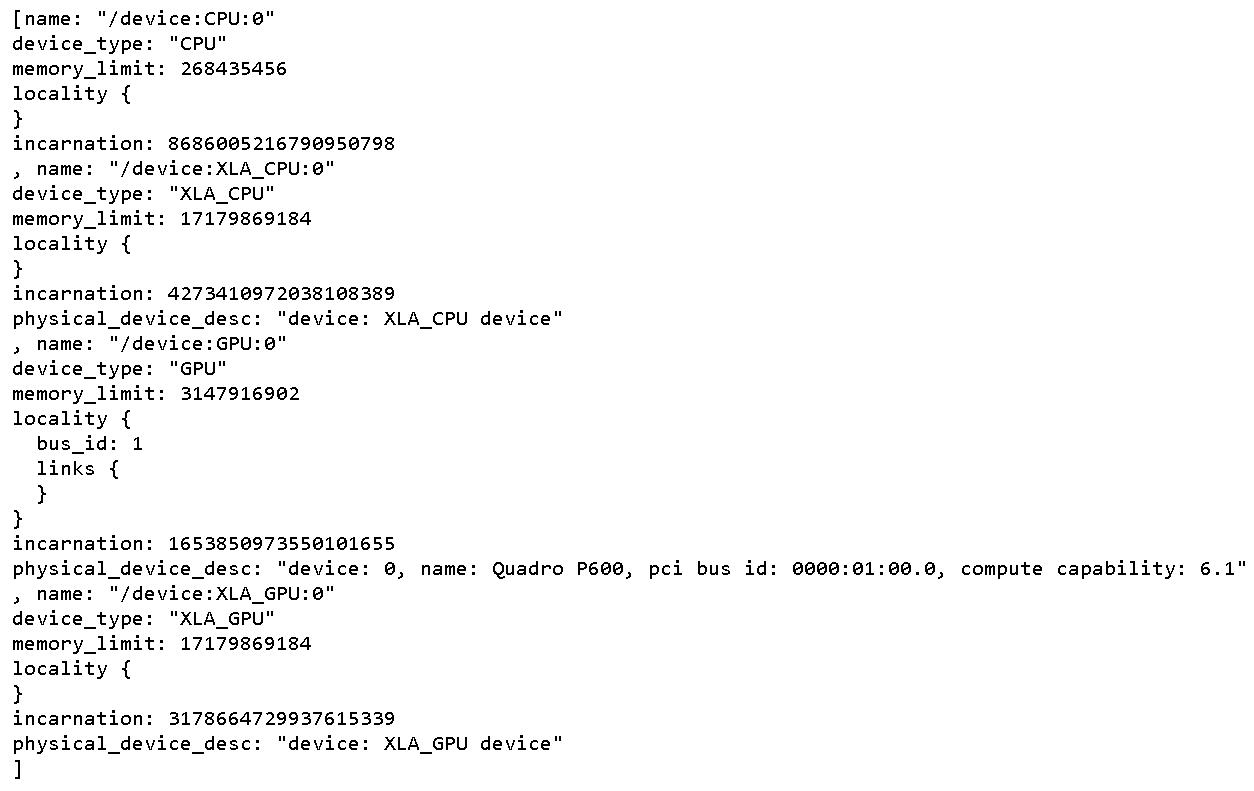

Pour tout vérifier physique Périphériques GPU disponible pour TensorFlow. Exécutez le code suivant

From tensorflow.python.client import device_lib

print(device_lib.list_local_devices())

Cela imprime tous les appareils disponibles pour Tensorflow

Pour vérifier si CUDA est activé pour TensorFlow, exécuter le code suivant

Import tensorflow as tf

print(tf.test.is_built_with_cuda())

La sortie sera une valeur booléenne qui renvoie true si TensorFlow est compilé avec CUDA

Pour savoir si le GPU se réveille pendant l'exécution, démarrer l'exécution de tout réseau de neurones complexe.

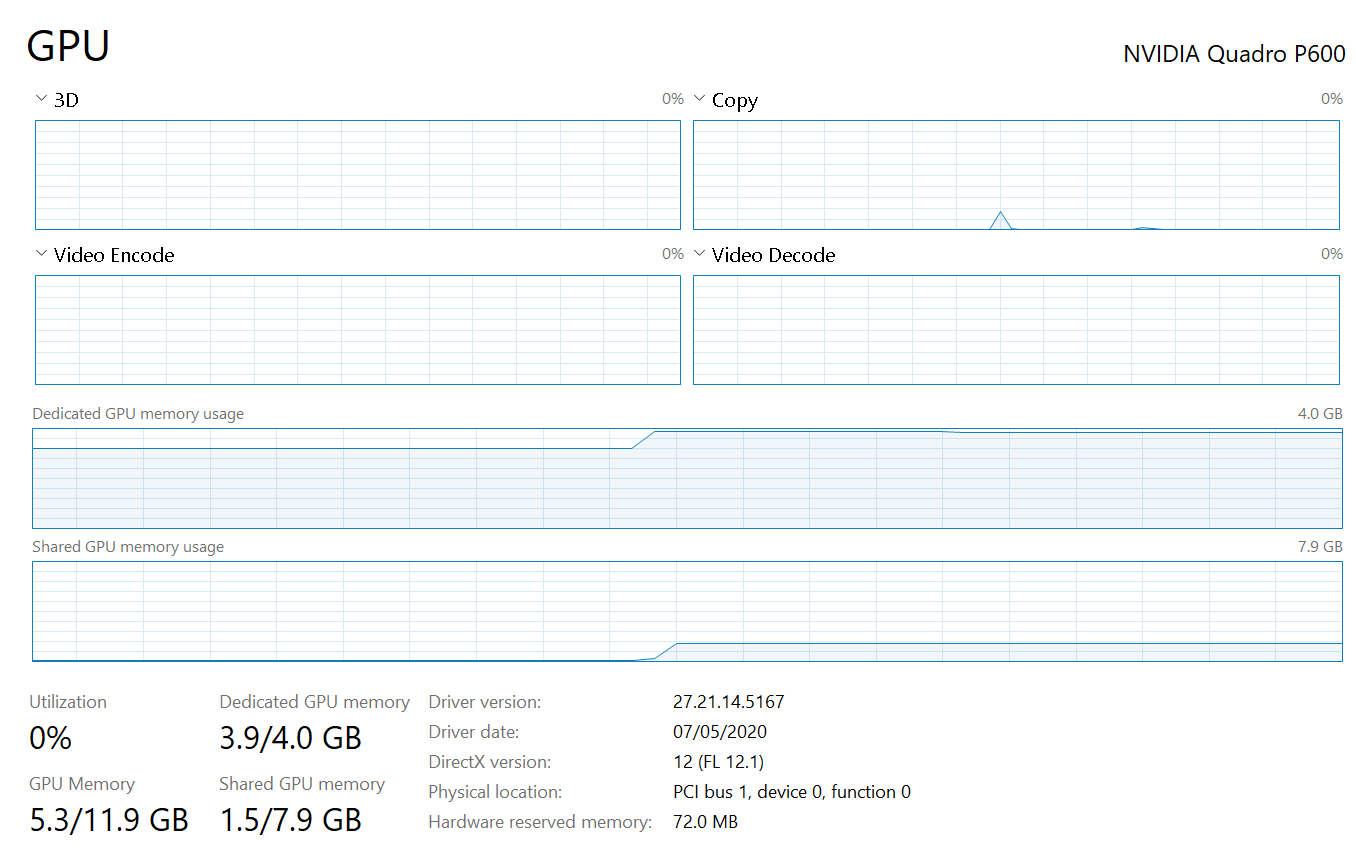

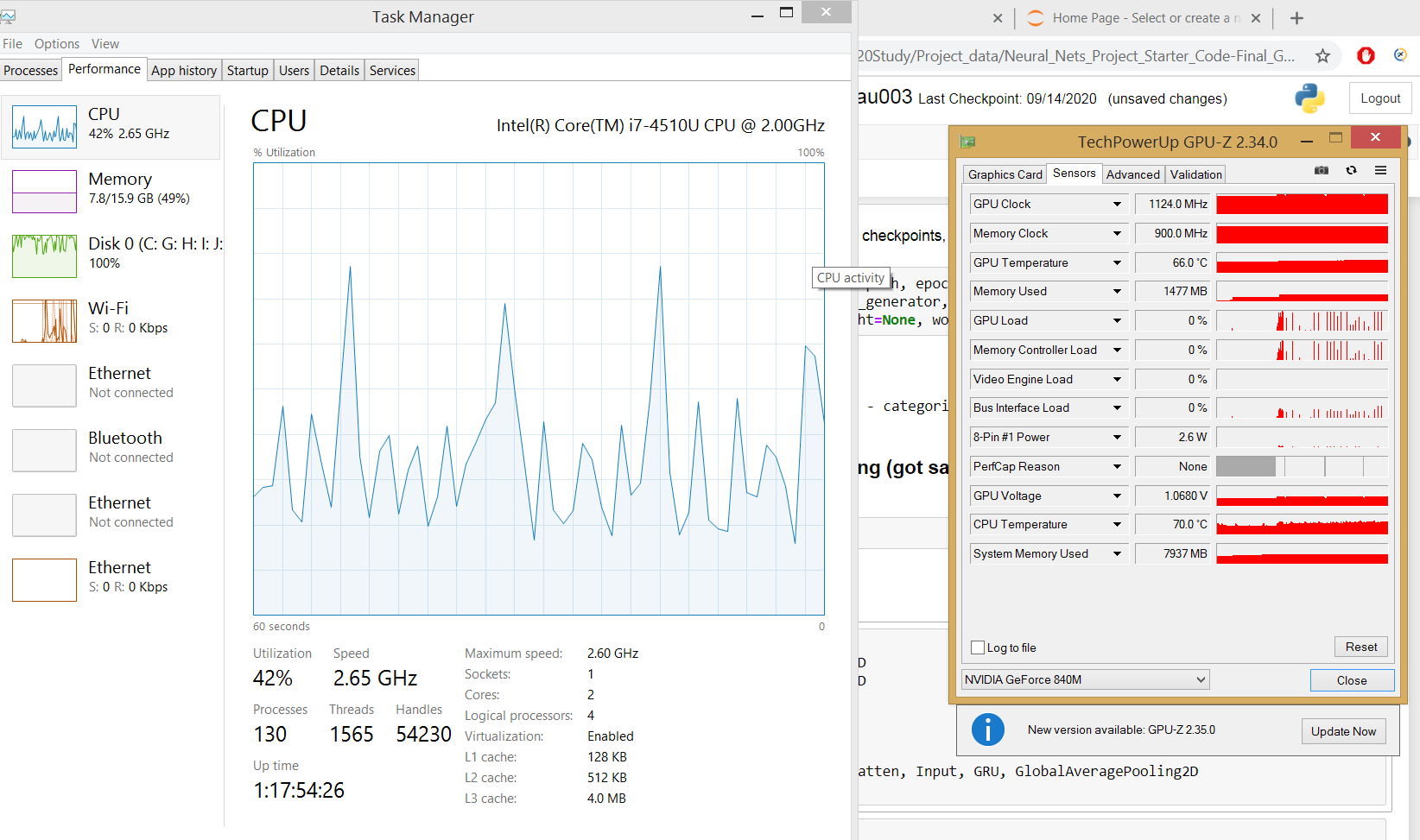

Le gestionnaire de tâches affiche l'utilisation du GPU et la mémoire occupée pour l'exécution du programme Tensorflow.

si l'onglet processus du gestionnaire de tâches n'affiche pas l'utilisation du GPU, qui est un scénario pour les machines fonctionnant sur le système d'exploitation Windows 8.1, utiliser des outils tiers comme GPUZ pour observer l'utilisation du GPU

Maintenant, l'installation et la configuration complètes du GPU sont terminées.

conclusion

-

- Il existe de nombreuses plateformes de cloud computing GPU gratuites qui pourraient accélérer nos calculs GPU dans les réseaux de neurones profonds. Alors essayez-les si votre machine ne contient pas de GPU dédié.

- Toutes les étapes d'installation ci-dessus dépendent les unes des autres, nous devons donc suivre la même séquence que mentionné ci-dessus.

- Il n'y a aucun moyen de déboguer pourquoi notre machine ne peut pas consommer de GPU dédié, alors ne manquez aucune des étapes.