introduzione

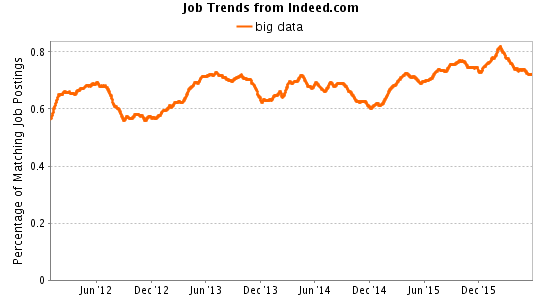

Diverse aziende hanno investito molto nei Big Data negli ultimi anni. Questo aumento nell'uso dell'analisi dei big data ha portato a una forte domanda di professionisti qualificati dei big data.. Sebbene ci sia stato molto dibattito sull'utilità di questa spesa, c'è un netto aumento di posti di lavoro nei Big Data. Ecco cosa dice una rapida ricerca:

Visto il forte aumento della domanda, i big data sono diventati un'area redditizia per potenziare le tue capacità. Nonostante questo, se sei uno come me, hai bisogno di una buona panoramica e comprensione dei vantaggi pratici prima di imparare qualcosa in modo più formale, probabilmente avrai difficoltà a trovare risorse strutturate come ho fatto io molto tempo fa.

Ci sono molte tecnologie e terminologie associate ai Big Data, che può fungere da ulteriore ostacolo per iniziare. Nomi come Hadoop, Riduci mappaMapReduce è un modello di programmazione progettato per elaborare e generare in modo efficiente set di dati di grandi dimensioni. Sviluppato da Google, Questo approccio suddivide il lavoro in attività più piccole, che sono distribuiti tra più nodi in un cluster. Ogni nodo elabora la sua parte e poi i risultati vengono combinati. Questo metodo consente di scalare le applicazioni e gestire enormi volumi di informazioni, essere fondamentali nel mondo dei Big Data...., Scintilla, MongoDB, AlveareHive è una piattaforma di social media decentralizzata che consente ai suoi utenti di condividere contenuti e connettersi con gli altri senza l'intervento di un'autorità centrale. Utilizza la tecnologia blockchain per garantire la sicurezza e la proprietà dei dati. A differenza di altri social network, Hive consente agli utenti di monetizzare i propri contenuti attraverso ricompense in criptovalute, che incoraggia la creazione e lo scambio attivo di informazioni.... Ci vuole un po' di tempo per abituarsi! Dopo aver ricevuto una risposta travolgente nel mio post precedente sui migliori video di YouTube sull'apprendimento automatico, apprendimento profondoApprendimento profondo, Una sottodisciplina dell'intelligenza artificiale, si affida a reti neurali artificiali per analizzare ed elaborare grandi volumi di dati. Questa tecnica consente alle macchine di apprendere modelli ed eseguire compiti complessi, come il riconoscimento vocale e la visione artificiale. La sua capacità di migliorare continuamente man mano che vengono forniti più dati lo rende uno strumento chiave in vari settori, dalla salute..., reti neurali e osservare la mancanza di risorse strutturate, La soluzione era semplice! Ecco un altro speciale di YouTube per aspiranti Big Data: Solo la mia opinione sull'immersione nei Big Data!!

Disclaimer: NON intendiamo promuovere alcun marchio o servizio attraverso questo post.. I video elencati in questo post si concentrano esclusivamente sulla loro rilevanza / utile al pubblico.

Chi dovrebbe trarre il massimo beneficio dalla visione di questi video?

Ho scritto questo post pensando alla confraternita dei principianti dei Big Data. Perché, questo post è più adatto per i candidati che vogliono iniziare la loro carriera nell'analisi dei big data. Se sei già un professionista con esperienza nei big data, è possibile che questo post non sia quello che stai cercando. Nonostante questo, può ancora consumare “ispirazione” dei TED talk elencati di seguito.

La struttura di questo post è progettata per fornire una descrizione completa delle varie tecnologie utilizzate in Big Data Analytics. I discorsi TED mostrati all'inizio hanno lo scopo di aggiungere un pizzico di ispirazione al tuo viaggio di apprendimento.. Questi colloqui ti offrono di immaginare un mondo emozionante guidato dai numeri, tecnologie e analisi dei big data.

TED parla sui Big Data

1. Introduzione ai Big Data di Hilary Mason, Capo Data Scientist di Bitly

Durata: 11:30 min

Riepilogo: In questo breve video, Hilary parla dell'ascesa dei big data e di come influenzeranno il nostro ambiente di lavoro. Evidenzia anche i piccoli ma significativi cambiamenti che i big data portano., inclusa la CPU, dati e algoritmi. Dopo, esamina il profilo di un data scientist nel tuo stile. Evidenzia le applicazioni per i big data e il loro utilizzo nel nostro quotidiano.

2. Grandi dati, Mondo piccolo: Kirk Borne in TEDxGeorgeMasonU

Durata: 22:00 min

Riepilogo: Il dottore. Kirk Borne inizia parlando del suo viaggio per diventare un data scientist. Dopo, copre alcune delle migliori idee applicate dietro il data mining e come può essere applicato alla nostra vita quotidiana. Parla anche del "fenomeno del piccolo mondo"’ e la "separazione di" 6 gradi'. Dopo, rivela alcune sorprendenti statistiche sui big data che assicurano che il mondo futuro sarà guidato dai dati.

3. Kenneth Zucchero: I big data sono dati migliori

Durata: 16:00 min

Riepilogo: Kenneth è fortemente concentrato sull'utilizzo dei dati disponibili a livello granulare. Ogni byte di dati ha qualcosa da rivelare, tutto ciò di cui hai bisogno è un ingegnere per scoprirlo. Lui crede che, con la quantità di informazioni disponibili, possiamo trovare le risposte a tutte le domande a cui era difficile pensare. I dati ci hanno reso più potenti. I dati possono essere il nostro più grande potere se li disponiamo intuitivamente.

4. Cosa fare con tutti questi Big Data??

Durata: 12:29 min

Riepilogo: Susan crede ‘Non siamo consumatori passivi di dati e tecnologia. Piuttosto, diamo forma ai dati e gli diamo un significato.'. In questo breve video, condivide il suo punto di vista sull'ascesa dei big data e le diverse alternative per utilizzare i dati per il loro uso ottimale. I dati non creano significato, noi facciamo. I dati ci forniscono un vasto oceano di informazioni che devono essere agitate per estrarre informazioni utili.

5. Come trovare il peggior posto dove parcheggiare a New York usando i Big Data?

Durata: 11:53 min

Riepilogo: Il titolo dice tutto. L'altoparlante utilizza le statistiche e la visualizzazione per dedurre il posto peggiore per parcheggiare a New York. Assicurati di non perdere nessuna informazione importante, quindi ha catturato tutte le variabili importanti nelle sue rappresentazioni grafiche. Se in qualsiasi momento volessi vedere l'utilizzo dei dati in tempo reale, da non perdere.

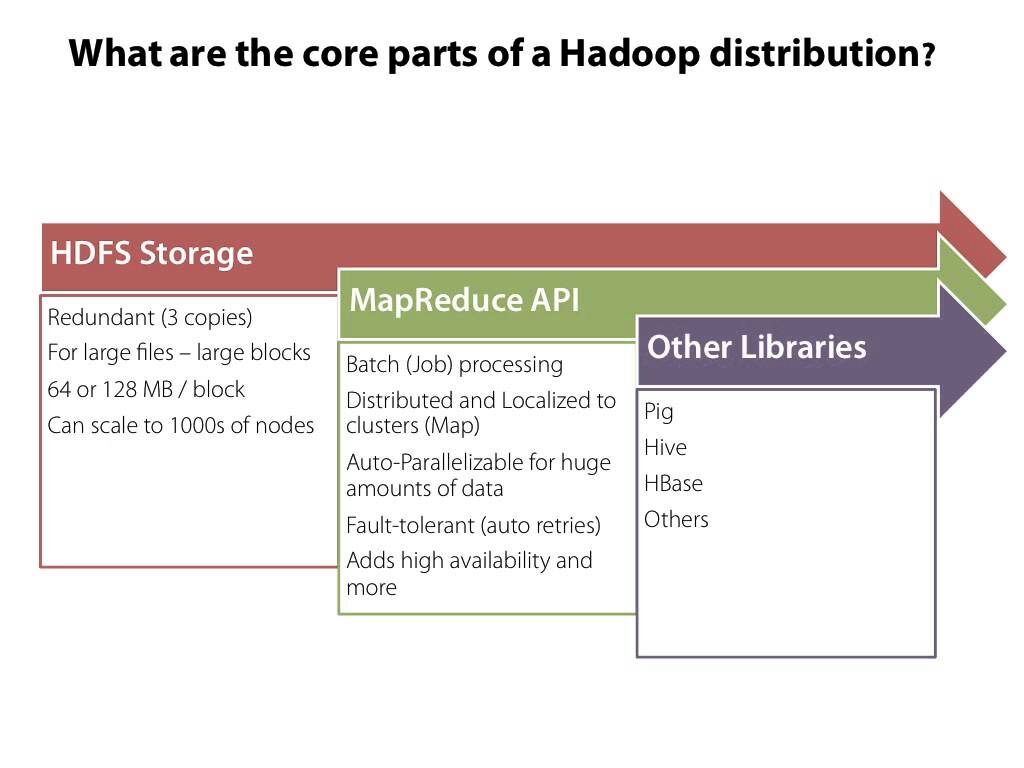

Conosci le terminologie dei Big Data

Consiglio vivamente questi video di YouTube alle persone che non conoscono l'analisi dei big data.. Guarda questi video veloci (~ 3 minuti) darti una chiara panoramica delle diverse tecnologie dei big data e delle relazioni tra di esse.

1. Cos'è HBase? Durata – 3 minuti

2. Cos'è Hadoop?? Durata – 3:12 min

3. Cos'è MapReduce? Durata – 2:39 min

4. Cos'è l'HDFS? Durata – 2:51 min

5. Cos'è Flume? Durata – 2:59 min

6. Cos'è PIG? Durata – 3:01 minuti

7. Cos'è Hive? Durata – 2:52 min

8. Cos'è Avro? Durata – 3:00 min

9. Cos'è Oozie?? Durata – 2:28 min

10. Cos'è Zookeeper?? Durata – 3:26 minuti

10 tutorial sull'analisi dei Big Data

1. Workshop sul corso accelerato Hadoop

Durata – 55:32 minuti

Riepilogo: Come suggerisce il nome, questo video copre tutto su Hadoop e il relativo concetto in meno di un'ora. L'oratore inizia con una rapida introduzione ad Hadoop, seguita da una spiegazione dettagliata dell'ecosistema e della distribuzione di Hadoop, HDFSHDFS, o File system distribuito Hadoop, Si tratta di un'infrastruttura chiave per l'archiviazione di grandi volumi di dati. Progettato per funzionare su hardware comune, HDFS consente la distribuzione dei dati su più nodi, garantire un'elevata disponibilità e tolleranza ai guasti. La sua architettura si basa su un modello master-slave, dove un nodo master gestisce il sistema e i nodi slave memorizzano i dati, facilitare l'elaborazione efficiente delle informazioni... Dopo, Spiega più componenti Hadoop come Mapreduce, FilatoYARN è un gestore di pacchetti per JavaScript che consente l'installazione e la gestione efficiente delle dipendenze nei progetti di sviluppo. Sviluppato da Facebook, Si caratterizza per la sua velocità e sicurezza rispetto ad altri gestori. YARN utilizza un sistema di cache per ottimizzare le installazioni e fornisce un file di blocco per garantire la coerenza delle versioni delle dipendenze tra i diversi ambienti di sviluppo...., Carnagione usando alcune storie interessanti. In conclusione, concludi questo corso accelerato rivelando alcuni dei modi non così popolari ma super utili per accedere ai dati.

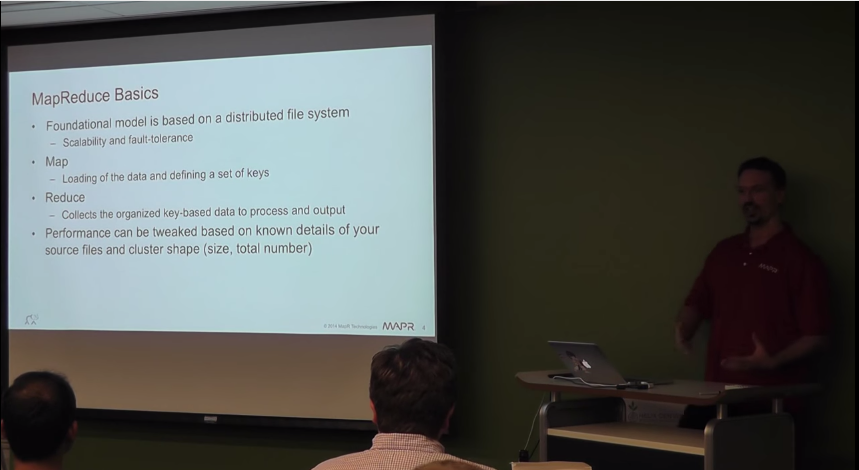

2. Fondamenti di MapReduce

Durata – 32:03 minuti

Riepilogo: Questo è un tutorial completo per imparare le basi di MapReduce. Questa serie di tutorial è divisa in 5 parti, ognuno dei quali copre uno specifico modulo MapReduce. Questo video introduttivo su MapReduce fornisce una descrizione dettagliata della sua rilevanza, opportunità di lavoro associate, applicazioni e uso. UN misuraIl "misura" È un concetto fondamentale in diverse discipline, che si riferisce al processo di quantificazione delle caratteristiche o delle grandezze degli oggetti, fenomeni o situazioni. In matematica, Utilizzato per determinare le lunghezze, Aree e volumi, mentre nelle scienze sociali può riferirsi alla valutazione di variabili qualitative e quantitative. L'accuratezza della misurazione è fondamentale per ottenere risultati affidabili e validi in qualsiasi ricerca o applicazione pratica.... che naviga attraverso le seguenti parti, tratterà gli argomenti essenziali di MapReduce. Dai un'occhiata alla sezione Avanti già che ci sei!!

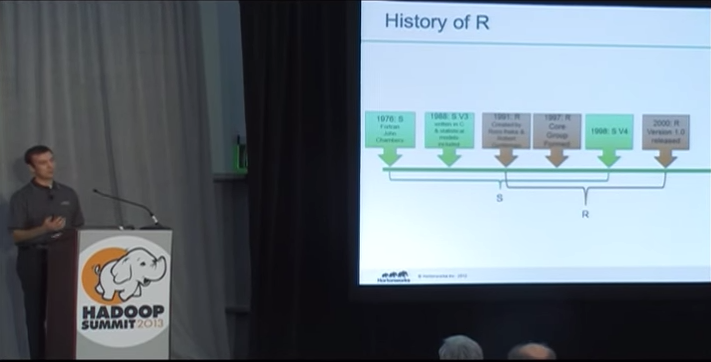

3. Abilita R in Hadoop

Durata – 40:25 minuti

Riepilogo: Questo tutorial ti insegna la conoscenza dell'integrazione di Hadoop con R. L'altoparlante segue una procedura passo passo per l'installazione di Hadoop in R. Sono stati discussi concetti come RHadoop, RHive e diverse librerie R associate. Allo stesso tempo, discute ulteriormente il variegato uso di R e come la programmazione R si è evoluta nel corso degli anni.

4. Introduzione al deep learning in Hadoop

Durata – 41: 14minuti

Riepilogo: L'oratore spiega meravigliosamente il concetto di deep learning usando hadoop. Il deep learning è uno degli argomenti più discussi nella comunità della scienza dei dati. Scienziati e ricercatori stanno lavorando duramente per scoprire nuovi modelli utilizzando il deep learning. Il concetto di deep learning è stato spiegato in modo semplicistico in questo video. Inoltre, sono state discusse questioni come le reti di credenze profonde, l'implementazione di Hadoop / FILATO.

5. Introduzione ad Apache Cassandra

Durata – 1:15:06 ora

Riepilogo: Ho trovato pochissimi video su Apache Cassandra, ma questo compensa tutto. Ecco un'introduzione completa ad Apache Cassandra da zero. L'ascesa di Apache Cassandra sta attirando l'attenzione di aziende e professionisti di tutto il mondo. in questo video, il relatore spiega gli algoritmi utilizzati, le sue caratteristiche essenziali, vantaggi e concetto / causa dietro il lancio di Apache Cassandra ~ 6 anni fa.

6. Introduzione a PIG

Durata – 30:56 minuti

Riepilogo: Questo è un tutorial completo per conoscere MAIALEIl maiale, un mammifero addomesticato della famiglia dei Suidi, È noto per la sua versatilità in agricoltura e nella produzione alimentare. Originario dell'Asia, Il suo allevamento si è diffuso in tutto il mondo. I maiali sono onnivori e hanno un'elevata capacità di adattarsi a vari habitat. Cosa c'è di più, svolgono un ruolo importante nell'economia, Fornitura di carne, cuoio e altri prodotti derivati. Anche la loro intelligenza e il loro comportamento sociale sono .... In questo tutorial, l'istruttore inizia fornendo una panoramica di Pig seguita dal confronto tra Pig e SQL. Dal momento che entrambi sono molto simili, fa un confronto interessante. Spiega anche sull'uso del maiale latino. Soprattutto questo, Inoltre, sono state illustrate le fasi di base dell'installazione di Pig..

7. Una panoramica di Apache Spark

Durata – 1:06:14 ora

Riepilogo: Questo tutorial giustifica adeguatamente il suo titolo insegnando la tecnologia Spark e come può aiutare a plasmare il mondo.. La guida inizia con una rapida rassegna di mapreduce seguita da spark e il vantaggio di utilizzare questa tecnologia. L'oratore ha spiegato meravigliosamente questi concetti.

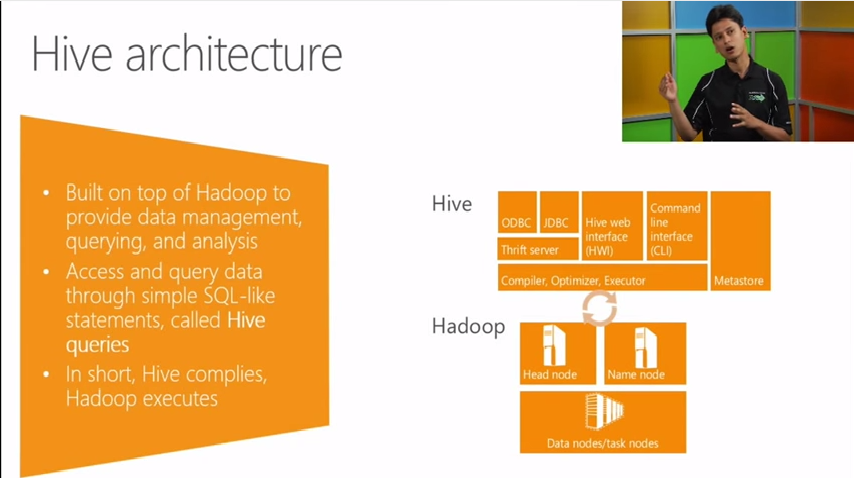

8. Introduzione a Hive e HiveQL

Durata – 1:06:19 ora

Riepilogo: Hive è basato su hadoop per fornire la gestione, query e analisi dei dati. Questo tutorial analizza l'architettura dell'alveare, operazioni dell'alveare e altre funzioni associate. Questo tutorial non solo ti arricchisce di conoscenze teoriche, ma mostra anche l'aspetto pratico e lo dimostra nel terminale.

9. Introduzione a NoSQL

Durata – 54:51 minuti

Riepilogo: Questo è uno dei migliori video che ho trovato sui database NoSQL. Troverai un'introduzione ai database NoSQL insieme a tutte le altre conoscenze essenziali di questo concetto che dovresti avere. Questo tutorial copre l'applicazione, i vantaggi, gli svantaggi, Compatibilità, l'utilizzo, le caratteristiche e altre caratteristiche essenziali di NoSQL. Consiglierò questo video a tutti.

10. Tutorial MongoDB per principianti

Durata – 4:34:47 ora

Riepilogo: Se in qualsiasi momento hai desiderato imparare MongoDB, qui hai la risorsa completa. Questo tutorial copre in modo completo tutti gli aspetti dei database MongoDB e NoSQL. Nonostante questo, sembra essere abbastanza lungo (> 4 ore), puoi vedere questi tutorial nelle pause. Una conoscenza preliminare di Javascript sarebbe vantaggiosa per imparare MongoDB attraverso questo tutorial. Questo tutorial inizia con un'introduzione ai database NoSQL seguita da una spiegazione di mongodb, come eseguire query mongodb, nodo.js, elaborazione avanzata dei dati e metodo per imparare mongodb su ubuntu nel cloud.

Risorsa alternativa: Corso MongoDB su Udacity

Note finali

Se hai visto i video elencati sopra, sarai già dotato di elementi essenziali di Big Data. In questo post, Ho presentato i video di YouTube e le conferenze TED più utili che ho trovato su Internet. I video elencati hanno lo scopo di sviluppare le tue basi sui big data e facilitare il tuo percorso di apprendimento.

Se vuoi ottenere i massimi benefici da questi video, Insistere per prendere appunti e sporcarsi le mani mentre guardi questi video. Nel caso mi fossi perso un video importante, sentiti libero di menzionarlo nella sezione commenti qui sotto.