Panoramica

- Come si divide un albero decisionale?? Quali sono i diversi criteri di suddivisione quando si lavora con gli alberi decisionali??

- Scopri tutto sui metodi di suddivisione dell'albero decisionale qui e padroneggia un popolare algoritmo di apprendimento automatico

introduzione

Gli alberi decisionali sono semplici da implementare e altrettanto facili da interpretare. Mi affido spesso ad alberi decisionali come il mio algoritmo di apprendimento automatico, che tu stia iniziando un nuovo progetto o gareggiando in un hackathon.

E gli alberi decisionali sono anche un'idea per i neofiti dell'apprendimento automatico!! Ma le domande da fare (e conosci la risposta) figlio:

- Come si divide un albero decisionale??

- Quali sono i diversi criteri di suddivisione??

- Qual è la differenza tra Gini e Information Gain?

Se non sei sicuro nemmeno di una di queste domande, Siete venuti nel posto giusto! Decision Tree è un potente algoritmo di apprendimento automatico che funge anche da base per altri algoritmi di apprendimento automatico complessi e ampiamente utilizzati come foresta casuale, XGBoost, e LuceGBM. Potete immaginare perché è importante conoscere questo argomento!!

Le librerie di programmazione odierne hanno semplificato l'utilizzo di qualsiasi algoritmo di apprendimento automatico, ma questo ha il costo di un'implementazione nascosta, che è indispensabile per comprendere appieno un algoritmo. Un'altra ragione di questa lotta infinita è la disponibilità di più modi per dividere i nodi dell'albero decisionale, che aumenta la confusione.

Ti sei mai imbattuto in questa lotta?? Non sono riuscito a trovare una soluzione? In questo articolo, spiegherò 4 métodos simples para dividir un nodoNodo è una piattaforma digitale che facilita la connessione tra professionisti e aziende alla ricerca di talenti. Attraverso un sistema intuitivo, Consente agli utenti di creare profili, condividere esperienze e accedere a opportunità di lavoro. La sua attenzione alla collaborazione e al networking rende Nodo uno strumento prezioso per chi vuole ampliare la propria rete professionale e trovare progetti in linea con le proprie competenze e obiettivi.... en un árbol de decisión.

Presumo familiarità con le basi della regressione e degli alberi decisionali. Ecco due popolari corsi gratuiti per imparare rapidamente o rispolverare concetti chiave:

Terminologie di base dell'albero delle decisioni

Esaminiamo rapidamente le terminologie chiave relative agli alberi decisionali che userò in tutto l'articolo..

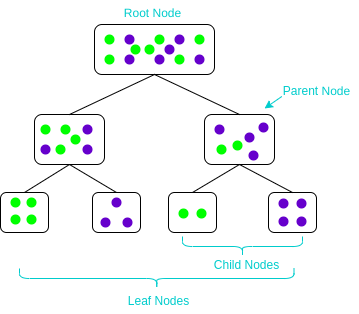

- Nodo padre-figlio: Un nodo diviso in sottonodi è noto come nodo principale, e questi sottonodi sono conosciuti come nodi figli. Poiché un nodo può essere suddiviso in più sottonodi, un nodo può agire come nodo genitore di molti nodi figli

- Nodo radice: Il nodo più alto in un albero decisionale. Non ha un nodo padre. Rappresenta l'intera popolazione o campione

- Nodi foglia / terminale: I nodi che non hanno nodi figlio sono noti come nodi terminali / foglia

Che cos'è la suddivisione dei nodi in un albero decisionale e perché viene eseguita??

Prima di imparare qualsiasi argomento, Penso che sia essenziale capire perché lo stai imparando. Questo aiuta a capire l'obiettivo di apprendere un concetto. Quindi, Capiamo perché conoscere la divisione dei nodi negli alberi decisionali.

Dal momento che tutti sanno quanto siano ampiamente utilizzati gli alberi decisionali, non si può negare il fatto che conoscere gli alberi decisionali è un must. Un albero decisionale prende decisioni dividendo i nodi in sottonodi. Questo processo viene eseguito più volte durante il processo di addestramento fino a quando rimangono solo nodi omogenei.. Ed è l'unico motivo per cui un albero decisionale può funzionare così bene. Perciò, la suddivisione dei nodi è un concetto chiave che tutti dovrebbero conoscere.

La divisione dei nodi, o solo la divisione, è il processo di divisione di un nodo in più sottonodi per creare nodi relativamente puri. Ci sono diversi modi per farlo, che possono essere suddivisi in due categorie in base al tipo di variabile target:

- Variabile obiettivo continua

- Variabile obiettivo categoriale

- Gini impurità

- Guadagno di informazioni

- Chi al quadrato

Nelle prossime sezioni, vedremo ogni metodo di divisione in dettaglio. Iniziamo con il metodo della prima divisione: riduzione della varianza.

Metodo di divisione dell'albero decisionale n. ° 1: riduzione della varianza

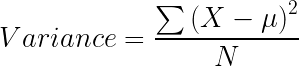

La riduzione della varianza è un metodo per dividere il nodo utilizzato quando la variabile target è continua, vale a dire, problemi di regressione. È così chiamato perché usa la varianza come misura per decidere la caratteristica in corrispondenza della quale il nodo è diviso in nodi figli.

La varianza viene utilizzata per calcolare l'omogeneità di un nodo. Se un nodo è completamente omogeneo, allora la varianza è zero.

Ecco i passaggi per dividere un albero decisionale riducendo la varianza:

- Per ogni divisione, calcolare individualmente la varianza di ogni nodo figlio

- Calcola la varianza di ogni divisione come varianza media ponderata dei nodi figli

- Seleziona la divisione con la varianza più bassa

- Eseguire i passaggi in 1 al 3 fino al raggiungimento di nodi completamente omogenei.

Il seguente video spiega in modo eccellente la riduzione della varianza usando un esempio:

Metodo di divisione dell'albero decisionale n. ° 2: guadagno di informazioni

Ora, ¿qué pasa si tenemos una variabileIn statistica e matematica, un "variabile" è un simbolo che rappresenta un valore che può cambiare o variare. Esistono diversi tipi di variabili, e qualitativo, che descrivono caratteristiche non numeriche, e quantitativo, che rappresentano quantità numeriche. Le variabili sono fondamentali negli esperimenti e negli studi, poiché consentono l'analisi delle relazioni e dei modelli tra elementi diversi, facilitare la comprensione di fenomeni complessi.... objetivo categórica? Ridurre la varianza non sarà sufficiente.

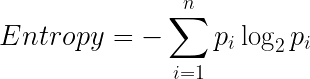

Bene, la risposta è ottenere informazioni. Il guadagno di informazioni viene utilizzato per dividere i nodi quando la variabile di destinazione è categoriale. Funziona sul concetto di entropia ed è dato da:

L'entropia viene utilizzata per calcolare la purezza di un nodo. Più piccolo è il valore di entropia, maggiore è la purezza del nodo. L'entropia di un nodo omogeneo è zero. Come sottraiamo l'entropia di 1, il guadagno di informazione è maggiore per i nodi più puri con un valore massimo di 1. Ora, Diamo un'occhiata alla formula per calcolare l'entropia:

Passaggi per dividere un albero decisionale utilizzando il guadagno di informazioni:

- Per ogni divisione, calcolare individualmente l'entropia di ogni nodo figlio

- Calcola l'entropia di ogni divisione come l'entropia media ponderata dei nodi secondari

- Seleziona la divisione con l'entropia più bassa o il guadagno di informazioni più alto

- Fino a raggiungere nodi omogenei, ripeti i passaggi 1-3

Ecco un video su come utilizzare il guadagno di informazioni per dividere un albero decisionale:

Metodo di divisione dell'albero decisionale # 3: Gini impurità

Gini Impurity è un metodo per dividere i nodi quando la variabile target è categorica. È il modo più popolare e semplice per dividere un albero decisionale. Il valore dell'impurità Gini è:

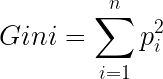

In attesa, Cos'è gini?

Gini è la probabilità di etichettare correttamente un elemento scelto casualmente se è stato etichettato casualmente in base alla distribuzione dell'etichetta al nodo. La formula di Gini è:

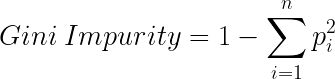

E Gini Impurity è:

Più bassa è l'impurità di Gini, maggiore è l'omogeneità del nodo. L'impurità Gini di un nodo puro è zero. Ora, potresti pensare che sappiamo già del guadagno di informazioni, poi, Perché abbiamo bisogno di Gini Impurity?

L'impurità Gini è preferita al guadagno di informazioni perché non contiene logaritmi che sono computazionalmente intensivi.

Ecco i passaggi per dividere un albero decisionale usando Gini Impurity:

- Simile a quello che abbiamo fatto per ottenere informazioni. Per ogni divisione, calcolare individualmente l'impurità Gini di ogni nodo figlio

- CCalcola l'impurità Gini di ogni divisione come la media pesata dell'impurità Gini dei nodi figli.

- Seleziona la divisione con il valore Gini Impurity più basso

- Fino a raggiungere nodi omogenei, ripeti i passaggi 1-3

Ed ecco Gini Impurity in formato video:

Metodo di divisione dell'albero decisionale # 4: Chi al quadrato

Il chi-quadrato è un altro metodo per dividere i nodi in un albero decisionale per i set di dati che hanno valori target categorici.. Può fare due o più di due divisioni. Lavora sulla significatività statistica delle differenze tra il nodo genitore e i nodi secondari.

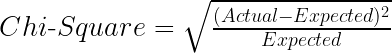

Il valore del chi quadrato è:

qui il Previsto è il valore atteso per una classe su un nodo figlio in base alla distribuzione delle classi sul nodo padre, e Vero è il valore reale di una classe in un nodo figlio.

La formula sopra ci dà il valore Chi-quadrato per una classe. Prendi la somma dei valori del Chi-quadrato per tutte le classi in un nodo per calcolare il Chi-quadrato per quel nodo. Più alto è il valore, maggiori sono le differenze tra i nodi padre e figlio, vale a dire, maggiore è l'omogeneità.

Questi sono i passaggi per dividere un albero decisionale usando Chi-Square:

- Per ogni divisione, Calcola individualmente il valore Chi-quadrato di ogni nodo figlio facendo la somma dei valori Chi-quadrato per ogni classe in un nodo.

- Calcola il valore Chi-quadrato di ogni divisione come somma dei valori Chi-quadrato per tutti i nodi figli

- Seleziona la divisione con il valore chi quadrato più alto

- Fino a raggiungere nodi omogenei, ripeti i passaggi 1-3

Certo, c'è un video che spiega Chi-Cuadrado nel contesto di un albero decisionale:

Note finali

Ora, conoscere i diversi metodi di divisione di un albero decisionale. Nei prossimi passi, puoi vedere il nostro playlist completa sugli alberi decisionali su youtube. Oppure puoi prendere il nostro gratuito corso sugli alberi decisionali qui.

Di seguito ho anche messo insieme un elenco di ottimi articoli sugli alberi decisionali.:

Se hai trovato questo articolo informativo, Condividilo con i tuoi amici e commenta qui sotto con le tue domande o pensieri.

Imparentato

Articoli correlati:

- Classificazione dell'albero decisionale | Guida alla classificazione dell'albero decisionale

- Albero decisionale Weka | Crea un albero decisionale con Weka

- Algoritmo dell'albero decisionale per la classificazione: apprendimento automatico 101

- Gini impurità | Divisione dell'albero decisionale con impurità di Gini