Introdução

Se existe uma área na ciência de dados que levou ao crescimento do aprendizado de máquina e da inteligência artificial nos últimos anos, é um aprendizado profundo. De laboratórios de pesquisa em universidades com pouco sucesso na indústria para alimentar todos os dispositivos inteligentes do planeta, aprendizagem profunda e redes neurais começaram uma revolução.

Observação: Se você está mais interessado em aprender conceitos em formato audiovisual, temos esse artigo completo explicado no vídeo abaixo. Sim, não é assim, você pode continuar lendo.

Neste artigo, vamos apresentar a você os componentes das redes neurais.

Blocos de construção de uma rede neural: camadas e neurônios

Hay dos bloques de construcción de una neuronal vermelhoAs redes neurais são modelos computacionais inspirados no funcionamento do cérebro humano. Eles usam estruturas conhecidas como neurônios artificiais para processar e aprender com os dados. Essas redes são fundamentais no campo da inteligência artificial, permitindo avanços significativos em tarefas como reconhecimento de imagem, Processamento de linguagem natural e previsão de séries temporais, entre outros. Sua capacidade de aprender padrões complexos os torna ferramentas poderosas.., vamos ver cada um deles em detalhes:

1. O que são camadas em uma rede neural?

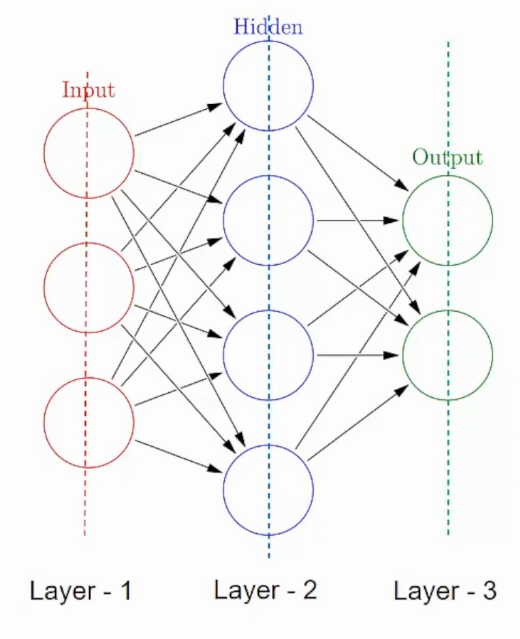

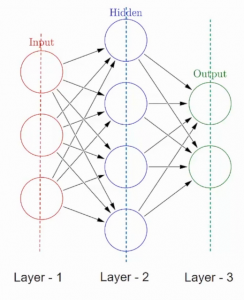

Uma rede neural é composta por componentes empilhados verticalmente chamados Capas. Cada linha pontilhada na imagem representa uma camada. Existem três tipos de camadas em um NN-

Camada de entradao "camada de entrada" refere-se ao nível inicial em um processo de análise de dados ou em arquiteturas de redes neurais. Sua principal função é receber e processar informações brutas antes de serem transformadas por camadas subsequentes. No contexto do aprendizado de máquina, A configuração adequada da camada de entrada é crucial para garantir a eficácia do modelo e otimizar seu desempenho em tarefas específicas....– Primeiro é a camada de entrada. Esta camada irá aceitar os dados e passá-los para o resto da rede.

Manto oculto– O segundo tipo de camada é chamado de camada oculta. Camadas ocultas são uma ou mais para uma rede neural. No caso acima, o número é 1. As camadas ocultas são as realmente responsáveis pelo excelente desempenho e complexidade das redes neurais. Eles executam várias funções ao mesmo tempo, como transformação de dados, criação automática de função, etc.

Camada de saídao "Camada de saída" é um conceito utilizado no campo da tecnologia da informação e design de sistemas. Refere-se à última camada de um modelo ou arquitetura de software que é responsável por apresentar os resultados ao usuário final. Essa camada é crucial para a experiência do usuário, uma vez que permite a interação direta com o sistema e a visualização dos dados processados....– O último tipo de camada é a camada de saída. A camada de saída contém o resultado ou saída do problema. As imagens brutas são passadas para a camada de entrada e recebemos a saída na camada de saída. Por exemplo-

Neste caso, estamos fornecendo uma imagem de um veículo e esta camada de saída fornecerá uma saída, um veículo de emergência ou não emergencial, depois de passar pelas camadas de entrada e ocultas, claro.

Agora que sabemos as camadas e suas funções, vamos falar em detalhes sobre do que cada uma dessas camadas é feita.

2. O que são neurônios em uma rede neural?

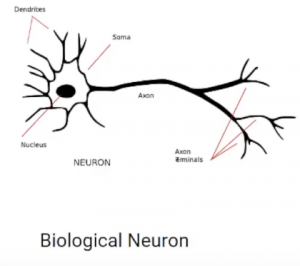

Uma camada consiste em pequenas unidades individuais chamadas neurônios. UMA neurônio em uma rede neural pode ser melhor compreendida com a ajuda de neurônios biológicos. Um neurônio artificial é semelhante a um neurônio biológico. Receba informações de outros neurônios, executa algum processamento e produz uma saída.

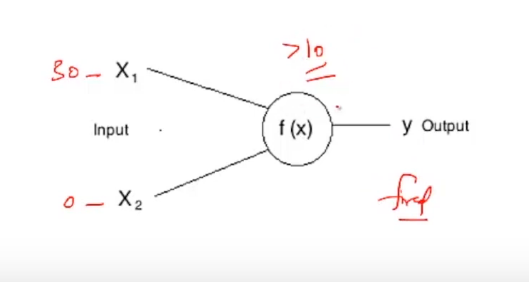

Agora vamos olhar para um neurônio artificial

Aqui, X1 e X2 são entradas para neurônios artificiais, f (X) representa o processamento realizado nas entradas e e representa a saída do neurônio.

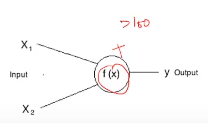

O que é o disparo de um neurônio?

Na vida real, todos nós ouvimos a frase: “Ative esses neurônios” de uma forma ou outra. O mesmo também se aplica a neurônios artificiais. Todos os neurônios têm tendência a disparar, mas apenas sob certas condições. Por exemplo-

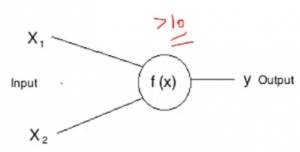

Se representarmos este f (X) por soma, então este neurônio pode disparar quando a soma for maior que, Digamos 100. Embora possa haver um caso em que o outro neurônio pode disparar quando a soma é maior do que 10-

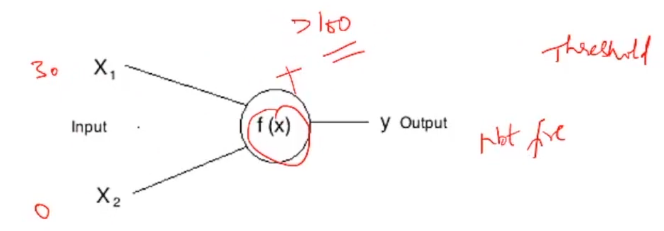

Essas certas condições que diferem de um neurônio para outro são chamadas Limiar. Por exemplo, se a entrada X1 no primeiro neurônio é 30 e X2 é 0:

Este neurônio não dispara, desde a soma 30 + 0 = 30 não é maior que o limite, quer dizer, 100. Considerando que se a entrada tivesse permanecido a mesma para o outro neurônio, este neurônio teria disparado desde a soma de 30 é maior do que o limite de 10.

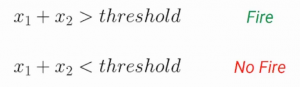

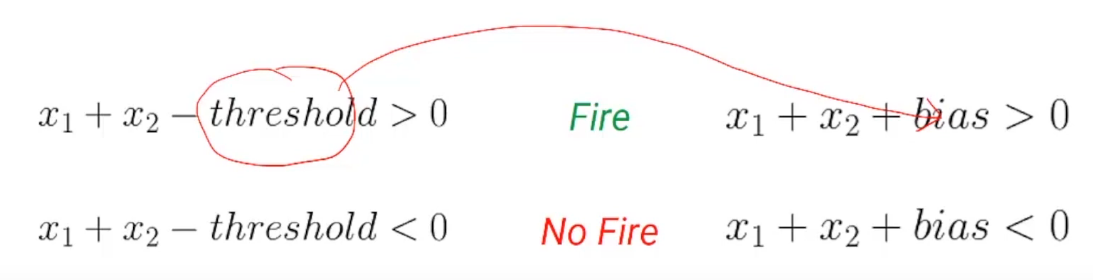

Agora, o limite negativo é chamado Tendência de um neurônio. Vamos representar isso um pouco matematicamente. Então, podemos representar a condição de disparo e não disparo de um neurônio usando este par de equações:

Se a soma das entradas for maior que o limite, o neurônio vai disparar. Pelo contrário, o neurônio não vai disparar. Vamos simplificar um pouco esta equação e trazer o limite para o lado esquerdo das equações. Agora, este limite negativo é chamado Tendência-

Uma coisa a ter em mente é que em uma rede neural artificial, todos os neurônios em uma camada têm o mesmo viés. Agora que temos um bom entendimento do viés e como ele representa a condição para um neurônio disparar, vamos passar para outro aspecto de um neurônio artificial chamado Pesos.

Até agora, mesmo em nosso cálculo, atribuímos a mesma importância a todas as entradas. Por exemplo-

Aqui X1 tem um peso de 1 e X2 tem um peso de 1 e o preconceito tem um peso de 1, mas e se quisermos ter diferentes pesos anexados a diferentes entradas?

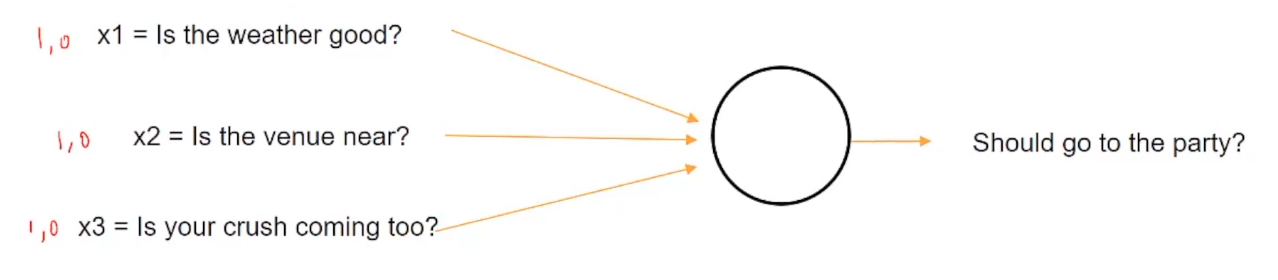

Vamos dar uma olhada em um exemplo para entender isso melhor. Suponha que hoje seja uma festa da faculdade e você tenha que decidir se vai ou não à festa com base em algumas condições de entrada, como está o tempo bom? O lugar é perto? Sua paixão está chegando?

Então, se o tempo estiver bom, será apresentado com um valor de 1, pelo contrário, 0. de forma similar, se o lugar é perto, será representado com 1, caso contrário, 0. E da mesma forma, se a pessoa de quem você gosta vai ou não vir à festa.

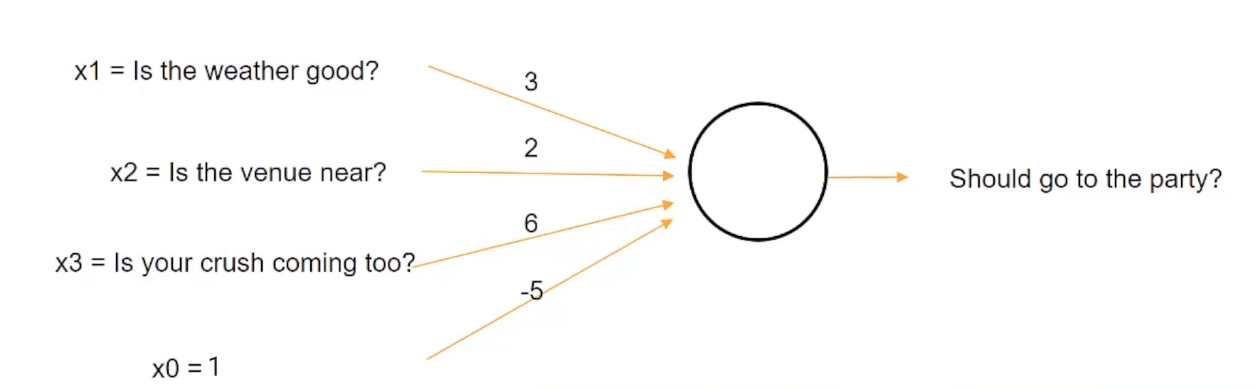

Agora suponha que ser um adolescente universitário, absolutamente adora a pessoa de quem gosta e pode dar o seu melhor para vê-la. Então você definitivamente irá para a festa, não importa como esteja o tempo ou quão longe o lugar esteja, então você vai querer atribuir mais peso a X3, que representa o esmagamento em comparação com as outras duas entradas.

Tal situação pode ser representada se atribuirmos pesos a uma entrada como esta:

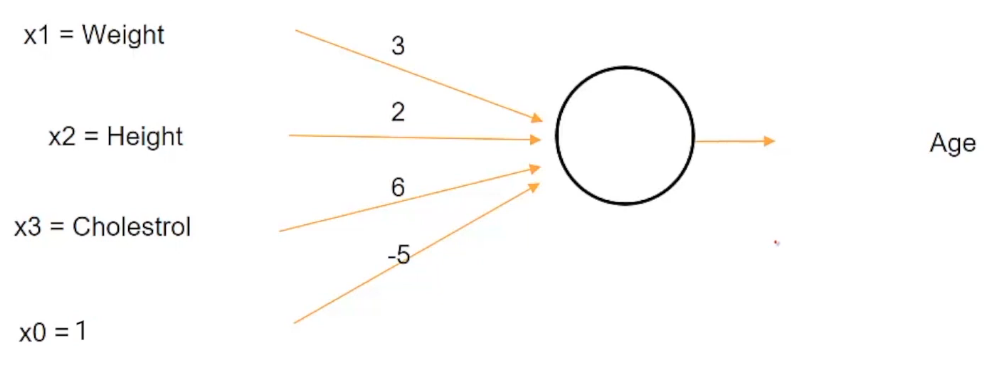

Podemos atribuir um peso de 3 para o clima, um peso de 2 para o lugar e um peso de 6 para se apaixonar. Contudo, se a soma desses três fatores, como está o tempo, o lugar e a paixão é maior do que um limiar de 5, então você pode decidir ir para a festa de outra forma.

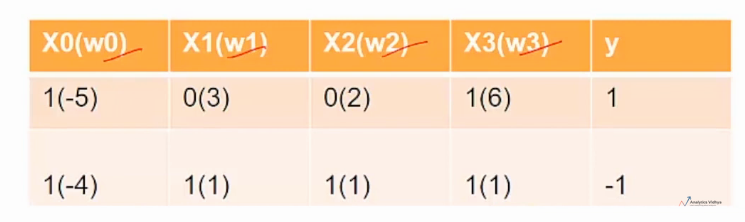

Observação: X0 é o valor de polarização

Então, por exemplo, inicialmente assumimos a condição em que se apaixonar é mais importante do que o clima ou o lugar em si.

Então vamos dizer, por exemplo, como representamos aqui, o clima (X1) está mal representado por 0 e o lugar (X2) é muito representado por 0, mas sua paixão (X3) vem para a festa que é representada por 1, então, quando você calcula a soma depois de multiplicar os valores de Xs com seus respectivos pesos, obtemos uma soma de 0 para o tempo (X1), 0 para Venue (X2) e 6 para esmagar (X3). Dado que 6 é maior do que o limite de 5, vai decidir ir para a festa. Por tanto, a saída (e) isto é 1.

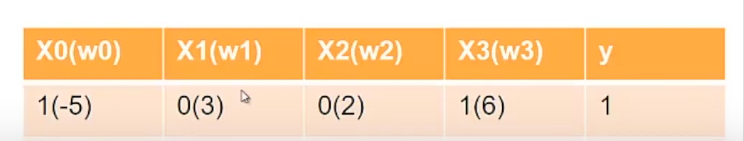

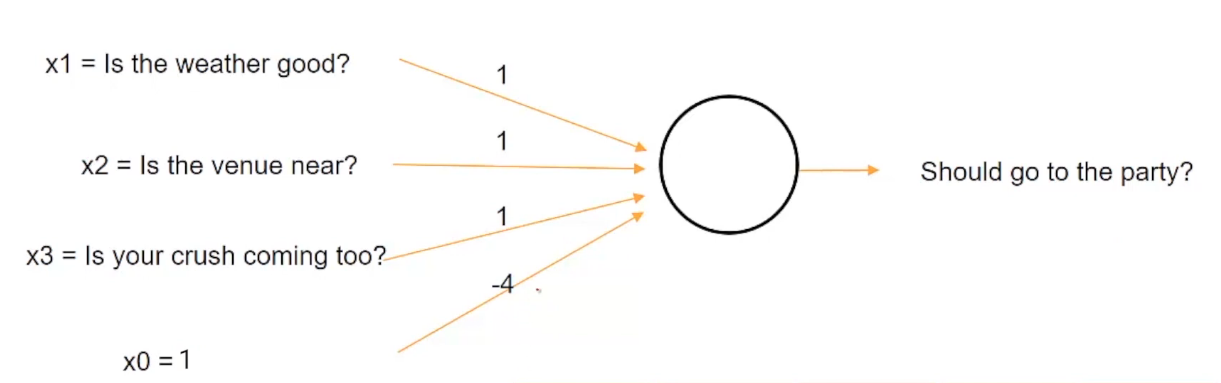

Agora imagine um cenário diferente. Imagine que você está doente hoje e não importa que você não vá à festa, então esta situação pode ser representada atribuindo o mesmo peso ao clima, o lugar e a paixão com o limiar de 4.

Agora, neste caso, estamos alterando o valor limite e definindo-o para um valor de 4, então mesmo se o tempo estiver bom, o lugar é próximo e a pessoa que você gosta está chegando, você não vai à festa desde a soma, quer dizer, 1 + 1 + 1 igual a 3, é menor que o valor limite de 4.

Estes w0, w1, w2 e w3 são chamados de pesos de neurônios e são diferentes para diferentes neurônios. Esses pesos são o que uma rede neural precisa aprender para tomar boas decisões.

Funções de ativação em uma rede neural

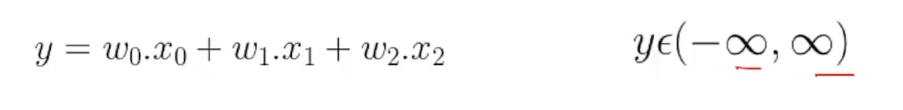

Agora que sabemos como uma rede neural combina diferentes entradas usando pesos, vamos passar para o último aspecto de um neurônio chamado Funções de gatilho. Até agora, o que estamos fazendo é apenas adicionar algumas entradas ponderadas e calcular algumas saídas, e esta saída pode ser lida de menos infinito a infinito.

Mas isso pode ser questionado em muitas circunstâncias. Suponha que primeiro queiramos estimar a idade de uma pessoa a partir de sua altura, peso e nível de colesterol e a seguir classificar a pessoa como idosa ou não, dependendo se a idade é mais velha do que 60 anos.

Contudo, se usarmos este determinado neurônio, então a idade de -20 é até possível. Você sabe que a faixa etária de acordo com a estrutura atual desse neurônio vai variar de -∞ a ∞. Então, até mesmo alguém com a idade como -20 é possível, dada essa faixa absurda de idade, ainda podemos usar nossa condição para decidir se uma pessoa é mais velha ou não. Por exemplo, se dissermos um determinado critério, como que uma pessoa é mais velha apenas se a idade for maior do que 60 anos. Então, mesmo que a idade seja -20, podemos usar este critério para classificar a pessoa como não mais velha.

Mas teria sido muito melhor se a idade tivesse feito muito mais sentido, como se a saída deste neurônio representando a idade estivesse na faixa de, Digamos, 0 uma 120. Então, Como podemos resolver este problema quando a saída de um neurônio não está em um determinado intervalo?

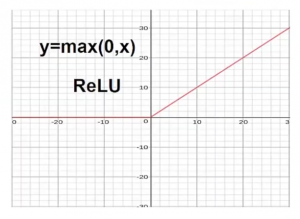

Um método é cortar a idade do lado negativo, seria usar uma função como máx. (0, X).

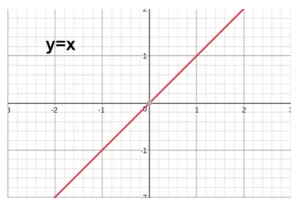

Agora vamos primeiro olhar para a condição original, antes de usar qualquer função. Para o X positivo, nós tivemos um Y positivo, e para o X negativo, tivemos um Y negativo. Aqui, o eixo x representa os valores reais ey representa os valores transformados.

Mas agora, se você quiser se livrar de valores negativos, o que podemos fazer é usar uma função como max (0, X). Ao usar esta função, qualquer coisa no lado negativo do eixo x é cortado para 0.

Este tipo de função é chamado Función retomarA função de ativação do ReLU (Unidade linear retificada) É amplamente utilizado em redes neurais devido à sua simplicidade e eficácia. Definido como ( f(x) = máx.(0, x) ), O ReLU permite que os neurônios disparem apenas quando a entrada é positiva, o que ajuda a mitigar o problema do desbotamento do gradiente. Seu uso demonstrou melhorar o desempenho em várias tarefas de aprendizado profundo, tornando o ReLU uma opção... e esses tipos de funções, que transformam a entrada combinada, são chamados Funções de gatilho. Então, ReLU es una função de despertarA função de ativação é um componente chave em redes neurais, uma vez que determina a saída de um neurônio com base em sua entrada. Seu principal objetivo é introduzir não linearidades no modelo, permitindo que você aprenda padrões complexos em dados. Existem várias funções de ativação, como o sigmóide, ReLU e tanh, cada um com características particulares que afetam o desempenho do modelo em diferentes aplicações.....

Dependendo do tipo de transformação necessária, pode haver diferentes tipos de funções de gatilho. Vamos dar uma olhada em alguns dos recursos de ativação mais populares:

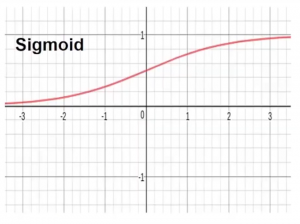

- Função de ativação sigmóide– Esta função transforma o intervalo de entradas combinadas em um intervalo entre 0 e 1. Por exemplo, se a saída for de menos de infinito a infinito, ela é representada pelo eixo x, a função sigmóide irá restringir este intervalo infinito a um valor entre 0 e 1.

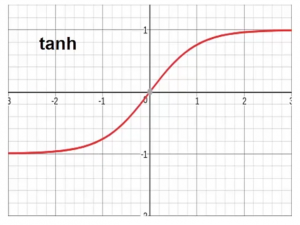

- Função de ativação Tanh Esta função transforma o intervalo de entradas combinadas em um intervalo entre -1 e 1. Tanh é muito semelhante à forma sigmóide, mas restringe o intervalo entre -1 e 1.

Notas finais

Até agora, Discutimos que a rede neural é composta de diferentes tipos de camadas empilhadas juntas e cada uma dessas camadas é composta de unidades individuais chamadas neurônios.. Cada neurônio tem três propriedades: o primeiro é tendencioso, o segundo é o peso e o terceiro é a função de gatilho.

O que mais, viés é o limite negativo após o qual você deseja que o neurônio dispare. Peso é como você define qual input é mais importante para os outros. A função Trigger ajuda a transformar a entrada ponderada combinada para organizá-la de acordo com a necessidade em mãos.

Eu recomendo fortemente que você consulte nosso Faixa preta com certificação AI e ML Mais Programa para começar sua jornada no fascinante mundo da ciência de dados e aprender esses e muitos outros tópicos.

Espero que este artículo funcione como un punto de partida para su aprendizaje hacia las redes neuronales y el aprendizado profundoAqui está o caminho de aprendizado para dominar o aprendizado profundo em, Uma subdisciplina da inteligência artificial, depende de redes neurais artificiais para analisar e processar grandes volumes de dados. Essa técnica permite que as máquinas aprendam padrões e executem tarefas complexas, como reconhecimento de fala e visão computacional. Sua capacidade de melhorar continuamente à medida que mais dados são fornecidos a ele o torna uma ferramenta fundamental em vários setores, da saúde....

Entre em contato conosco nos comentários abaixo se tiver alguma dúvida..