Introducción

La multicolinealidad puede ser difícil de pronunciar, pero es un tema que debe conocer en el campo del aprendizaje automático. Lo conozco debido a mi experiencia en estadística, pero he visto a muchos profesionales que no conocen que existe la multicolinealidad.

Esto es especialmente frecuente en aquellas personas con aprendizaje automático que provienen de una capacitación no matemática. Y aún cuando sí, es factible que la multicolinealidad no sea el tema más crucial para comprender en su viaje, sigue siendo lo suficientemente importante como para aprender. ¡Especialmente si está sentado para entrevistas con científicos de datos!

Entonces, en este post, entenderemos qué es la multicolinealidad, por qué es un obstáculo, qué causa la multicolinealidad y después entenderemos cómo detectar y corregir la multicolinealidad.

Antes de profundizar más, es imperativo tener un conocimiento básico de regresión y algunos términos estadísticos. Para esto, recomiendo encarecidamente consultar los siguientes recursos:

Tabla de contenido

- ¿Qué es la multicolinealidad?

- El problema de tener multicolinealidad

- ¿Qué causa la multicolinealidad?

- Detectando multicolinealidad con VIF

- Fijación de la multicolinealidad

¿Qué es la multicolinealidad?

La multicolinealidad ocurre cuando dos o más variables independientes están altamente correlacionadas entre sí en un modelo de regresión.

Esto significa que una variableEn estadística y matemáticas, una "variable" es un símbolo que representa un valor que puede cambiar o variar. Existen diferentes tipos de variables, como las cualitativas, que describen características no numéricas, y las cuantitativas, que representan cantidades numéricas. Las variables son fundamentales en experimentos y estudios, ya que permiten analizar relaciones y patrones entre diferentes elementos, facilitando la comprensión de fenómenos complejos.... independiente se puede predecir a partir de otra variable independiente en un Modelo de regresión. A modo de ejemplo, altura y peso, ingresos del hogar y consumo de agua, kilometraje y precio de un automóvil, tiempo de estudio y tiempo libre, etc.

Permítanme tomar un ejemplo simple de nuestra vida cotidiana para explicar esto. A Colin le encanta ver televisión mientras mastica patatas fritas. ¡Mientras más televisión mira, más patatas fritas come y más feliz se pone!

Ahora, si pudiéramos cuantificar la felicidad y medir la felicidad de Colin mientras está ocupado haciendo su actividad favorita, ¿cuál crees que tendría un mayor impacto en su felicidad? ¿Tomando patatas fritas o viendo la televisión? Eso es difícil de determinar debido a que en el momento en que intentamos medir la felicidad de Colin por comer papas fritas, comienza a mirar televisión. Y en el momento en que tratamos de medir su felicidad al ver televisión, comienza a comer papas fritas.

Comer patatas fritas y ver televisión están muy correlacionados en el caso de Colin y no podemos determinar individualmente el impacto de las actividades individuales en su felicidad. ¡Este es el problema de la multicolinealidad!

Entonces, ¿por qué debería preocuparse por la multicolinealidad en el aprendizaje automático ¿contexto? Respondamos esa pregunta a continuación.

El problema de tener multicolinealidad

La multicolinealidad puede ser un obstáculo en un modelo de regresión debido a que no podríamos distinguir entre los efectos individuales de las variables independientes sobre la variable dependiente. A modo de ejemplo, supongamos que en la próxima ecuación lineal:

Y = W0 + W1 * X1 + W2 * X2

El coeficiente W1 es el aumento en Y para un incremento unitario en X1 mientras se mantiene constante X2. Pero dado que X1 y X2 están altamente correlacionados, los cambios en X1 además causarían cambios en X2 y no podríamos ver su efecto individual en Y.

«Esto hace que los efectos de X1 en Y sean difíciles de distinguir de los efectos de X2 en Y».

Es factible que la multicolinealidad no afecte tanto a la precisión del modelo. Pero podríamos perder confiabilidad al determinar los efectos de características individuales en su modelo, y eso puede ser un obstáculo cuando se trata de interpretabilidad.

¿Qué causa la multicolinealidad?

La multicolinealidad podría ocurrir debido a los siguientes problemas:

- La multicolinealidad podría existir debido a los problemas en el conjunto de datos en el momento de la creación. Estos problemas podrían deberse a experimentos mal diseñados, datos de gran observación o la incapacidad de manipular los datos:

- A modo de ejemplo, determinar el consumo de electricidad de un hogar a partir de los ingresos del hogar y la cantidad de electrodomésticos. Aquí, sabemos que la cantidad de aparatos eléctricos en un hogar aumentará con los ingresos del hogar. A pesar de esto, esto no se puede borrar del conjunto de datos.

- La multicolinealidad además podría ocurrir cuando se crean nuevas variables que dependen de otras variables:

- A modo de ejemplo, la creación de una variable para el IMC a partir de las variables de altura y peso incluiría información redundante en el modelo.

- Incluyendo variables idénticas en el conjunto de datos:

- A modo de ejemplo, incluir variables de temperatura en Fahrenheit y temperatura en Celsius

- El uso inexacto de variables ficticias además puede causar un obstáculo de multicolinealidad. Esto se llama Trampa de variable ficticia:

- A modo de ejemplo, en un conjunto de datos que contiene la variable de estado de matrimonio con dos valores únicos: ‘casado’, ‘soltero’. La creación de variables ficticias para ambos incluiría información redundante. Podemos conformarnos con una sola variable que contenga 0/1 para el estado ‘casado’ / ‘soltero’.

- En algunos casos, los datos insuficientes además pueden causar problemas de multicolinealidad

Detectando multicolinealidad usando VIF

Intentemos detectar la multicolinealidad en un conjunto de datos para darle una idea de lo que puede salir mal.

He creado un conjunto de datos que determina el salario de una persona en una compañía en función de las siguientes características:

- Sexo (0 – mujer, 1 hombre)

- La edad

- Años de servicio (años de trabajo en la compañía)

- Nivel de educación (0 – sin educación formal, 1 – pregrado, 2 – posgrado)

La multicolinealidad se puede detectar a través de varios métodos. En este post, nos centraremos en el más común: VIF (factores variables de inflación).

”VIF determina la fuerza de la correlación entre las variables independientes. Se predice tomando una variable y haciendo una regresión frente a cualquier otra variable. «

o

La puntuación VIF de una variable independiente representa qué tan bien la variable es explicada por otras variables independientes.

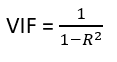

R ^ 2 El valor se determina para averiguar qué tan bien una variable independiente es descrita por las otras variables independientes. Un alto valor de R ^ 2 significa que la variable está altamente correlacionada con las otras variables. Esto es capturado por el VIF que se indica a continuación:

Entonces, cuanto más cerca R ^ 2 valor a 1, mayor es el valor de VIF y mayor es la multicolinealidad con la variable independiente particular.

- VIF comienza en 1 y no tiene límite superior

- VIF = 1, sin correlación entre la variable independiente y las otras variables

- VIF superior a 5 o 10 indica una alta multicolinealidad entre esta variable independiente y las demás

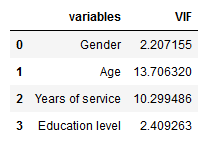

Podemos ver aquí que la ‘Edad’ y los ‘Años de servicio’ disponen un valor VIF alto, lo que significa que pueden predecirse a través de otras variables independientes en el conjunto de datos.

Aún cuando la matriz de correlación y los diagramas de dispersión además se pueden utilizar para hallar la multicolinealidad, sus hallazgos solo muestran la vinculación bivariada entre las variables independientes. Se prefiere VIF dado que puede mostrar la correlación de una variable con un grupo de otras variables.

Fijación de la multicolinealidad

Borrar una de las características correlacionadas ayudará a reducir la multicolinealidad entre las características correlacionadas:

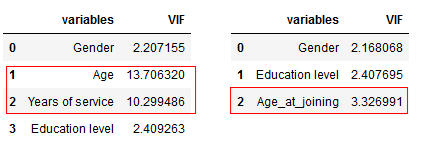

La imagen de la izquierda contiene el valor VIF original para las variables y la de la derecha es después de borrar la variable ‘Edad’.

Pudimos borrar la variable ‘Edad’ del conjunto de datos debido a que su información estaba siendo capturada por la variable ‘Años de servicio’. Esto ha reducido la redundancia en nuestro conjunto de datos.

La eliminación de variables debe ser un procedimiento iterativo que comienza con la variable que tiene el valor VIF más grande debido a que su tendencia es capturada en gran medida por otras variables. Si hace esto, notará que los valores de VIF para otras variables además se habrían reducido, aún cuando en distinto medida.

En nuestro ejemplo, después de borrar la variable ‘Edad’, los valores de VIF para todas las variables han disminuido en distinto medida.

A continuación, combine las variables correlacionadas en una y elimine las otras. Esto reducirá la multicolinealidad:

La imagen de la izquierda contiene el valor VIF original para las variables y la de la derecha es después de combinar la variable ‘Edad’ y ‘Años de servicio’. La combinación de ‘Edad’ y ‘Años de experiencia’ en una sola variable ‘Edad_en_unión’ nos posibilita capturar la información en ambas variables.

A pesar de esto, es factible que la multicolinealidad no sea un obstáculo siempre. La necesidad de corregir la multicolinealidad depende principalmente de las siguientes razones:

- Cuando le importa más cuánto afecta cada característica individual en lugar de un grupo de características a la variable de destino, entonces borrar la multicolinealidad puede ser una buena opción

- Si la multicolinealidad no está presente en las características que le interesan, es factible que la multicolinealidad no sea un obstáculo.

Notas finales

El conocimiento sobre la multicolinealidad puede resultar muy útil cuando se crean modelos de aprendizaje automático interpretables.

Espero que este post le haya resultado útil para comprender el problema de la multicolinealidad y cómo abordarlo. Si desea comprender otros modelos de regresión o desea comprender la interpretación del modelo, le recomiendo encarecidamente que lea los siguientes posts maravillosamente escritos:

Además debe consultar el curso Principios fundamentales de la regresión (sin costes) como siguiente paso.