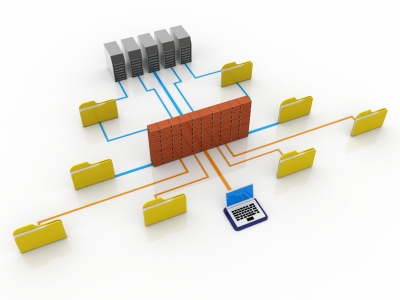

Hadoop, como se conoce, es un sistema open source basado en una arquitectura que trabaja con el nodo maestroEl "nodo maestro" es un componente clave en redes de computadoras y sistemas distribuidos. Se encarga de gestionar y coordinar las operaciones de otros nodos, asegurando una comunicación eficiente y el flujo de datos. Su función principal incluye la toma de decisiones, la asignación de recursos y la supervisión del rendimiento del sistema. La correcta implementación de un nodo maestro es fundamental para optimizar el funcionamiento general de la red.... y los nodos esclavos para crear un clústerUn clúster es un conjunto de empresas y organizaciones interconectadas que operan en un mismo sector o área geográfica, y que colaboran para mejorar su competitividad. Estos agrupamientos permiten compartir recursos, conocimientos y tecnologías, fomentando la innovación y el crecimiento económico. Los clústeres pueden abarcar diversas industrias, desde tecnología hasta agricultura, y son fundamentales para el desarrollo regional y la creación de empleo...., siempre desde un solo nodoNodo es una plataforma digital que facilita la conexión entre profesionales y empresas en busca de talento. A través de un sistema intuitivo, permite a los usuarios crear perfiles, compartir experiencias y acceder a oportunidades laborales. Su enfoque en la colaboración y el networking hace de Nodo una herramienta valiosa para quienes desean expandir su red profesional y encontrar proyectos que se alineen con sus habilidades y objetivos.... maestro y múltiples esclavos. Gracias a esta estructura, Hadoop es capaz de almacenar y analizar grandes volúmenes de datos, cientos de pentabytes e inclusive más.

Su núcleo nació como un conjunto de soluciones en el entorno Apache, bautizado con el nombre de Hadoop, y su arquitectura maestro / esclavo utiliza el nodo maestro para guardar los metadatos asociados con sus nodos esclavos dentro del bastidor del que forma parte. Por otra parte, el maestro mantiene el estado de sus nodos eslavos, mientras estos almacenan la información que está procesando en un momento específico.

Simplemente, es una tecnología que almacena enormes volúmenes de información y posibilita poner en práctica analíticaLa analítica se refiere al proceso de recopilar, medir y analizar datos para obtener información valiosa que facilite la toma de decisiones. En diversos campos, como los negocios, la salud y el deporte, la analítica permite identificar patrones y tendencias, optimizar procesos y mejorar resultados. El uso de herramientas avanzadas y técnicas estadísticas es fundamental para transformar datos en conocimiento aplicable y estratégico.... predictiva a partir de datos estructurados y no estructurados, que se ejecutan en un clúster Hadoop de un número específico de nodos.

Un ecosistema rico y en crecimiento

La comunidad internacional open source está refinando el núcleo de Hadoop mientras hace crecer su ecosistema con contribuciones constante. Dado que el original no cubre las necesidades, comienzan a aparecer funcionalidades, como ocurre con Chispa – chispear, que cumple con los requerimientos en tiempo real que un clúster de Hadoop tradicional no puede cumplir sin su ayuda. De esta forma, esa comunidad open source se encarga de mantener, corregir errores y otorgar nuevos paquetes para lograr nuevas funcionalidades.

Por su parte, distribuciones comerciales Toman el opensource de Apache y añaden nuevas funcionalidades que satisfagan los requisitos del mundo empresarial, con el fin de adaptarlo, puesto que el software opensource tiene la ventaja de ser sin costes, pero en un entorno corporativo se necesitan otras funcionalidades.

Adapte la arquitectura de Hadoop

En el momento de diseñar un clúster Tenemos que dar respuesta a una serie de preguntas clave que nos permitan adaptar la arquitectura Hadoop a las distintas necesidades de cada caso concreto. Tendremos que elegir con cuantos nodos Vamos a comenzar en base a aspectos como la cantidad de datos con los que vamos a trabajar, dónde se encuentran, su naturaleza …

Además será fundamental determinar qué quiero analizar, dónde recortar para viabilizar el procedimiento sin obstaculizar el logro del objetivo, que no es otro que descubrir tendencias y, en conclusión, comprender patrones que permitan la extracción de valor estratégico. .

El elección de distribución Hadoop dependerá de lo que nos ofrezca y de cómo se adapte a lo que buscas. La distribución gratuita de Hadoop se utiliza a menudo para realizar pruebas que, si disponen éxito, a menudo conducen a un caso de negocio económico que necesita una distribución comercial.

Aún así, el versión open source es una alternativa a comercial. Es cierto que no tendrán tantas aplicaciones corporativas y será más difícil de instalar y configurar, puesto que no tendremos asistente de instalación o configuración. Será más complejo poner en práctica un clúster de Hadoop y además faltará asistencia para implementarlo y corregir posibles errores.

El uso de Nube además puede servir como complemento poseer de herramientas que diseñen los análisis de forma más eficaz, aún cuando estos deben realizarse dentro del clúster. Un ejemplo podría ser el uso de herramientas de visualización que se ejecutarían en el clúster, no es necesario mover datos a la nube. En general, este tipo de ayudas se pueden usar para analizar, validar resultados, hacer comparaciones o para poder poner en práctica un sistema, digamos.

Fuente de la imagen: jscreationzs / FreeDigitalPhotos.net

Publicación relacionada: