Dieser Artikel wurde im Rahmen der Data Science Blogathon.

Überblick

- Grundlegendes zu GPUs in tiefes LernenTiefes Lernen, Eine Teildisziplin der Künstlichen Intelligenz, verlässt sich auf künstliche neuronale Netze, um große Datenmengen zu analysieren und zu verarbeiten. Diese Technik ermöglicht es Maschinen, Muster zu lernen und komplexe Aufgaben auszuführen, wie Spracherkennung und Computer Vision. Seine Fähigkeit, sich kontinuierlich zu verbessern, wenn mehr Daten zur Verfügung gestellt werden, macht es zu einem wichtigen Werkzeug in verschiedenen Branchen, von Gesundheit....

- Beginnend mit den Voraussetzungen für die Installation von TensorFlow -GPU.

- Einrichtung und Konfiguration der GPU-Umgebung.

- Testen und Überprüfen der GPU-Installation

„Die Grafik hat es geschafft

eine große Verschiebung hin zum maschinellen Lernen, bei dem es an sich um das Verstehen geht

Daten“

_ Jefferson Han, Gründer und leitender Wissenschaftler von Perceptive Pixel

Quelle: Google Bilder

GPUs beim Deep Learning verstehen

CPUs können Daten schneller abrufen, aber sie können nicht mehr Daten gleichzeitig verarbeiten, da die CPU viele Iterationen im Hauptspeicher durchführen muss, um eine einfache Aufgabe auszuführen. Zweitens, die GPU kommt mit eigenem VRAM-Speicher (Video-RAM) gewidmet, Daher, macht weniger Aufrufe in den Hauptspeicher, es ist also schnell

CPU führt Jobs sequentiell aus und hat weniger Kerne, GPUs verfügen jedoch über Hunderte kleinerer Kerne, die parallel arbeiten, was die GPU zu einer hochparallelen Architektur macht, was die Leistung verbessert.

Beginnend mit den Voraussetzungen für die Installation von TensorFlow – GPU

Die Tensorflow-GPU kann nur funktionieren, wenn Sie eine CUDA-fähige Grafikkarte haben. Alle neueren NVidia-Grafikkarten der letzten drei oder vier Jahre haben CUDA aktiviert.

Aber trotzdem, Lassen Sie uns eine Pause einlegen und prüfen, ob Ihre Grafikkarte CUDA-fähig ist, da "falsche Annahmen zu treffen, verursacht allen Schmerz und Leid", dijo Jennifer jung.

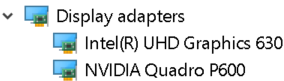

Um die Grafikkartendetails zu überprüfen. Öffnen Sie das Ausführungsfenster über das Startmenü und führen Sie Control . aus / Name Microsoft.DeviceManager. Grafikkarte wird unter Grafikkarten angezeigt

Jede Maschine wird mit integrierten Grafikkarten ausgestattet sein, die auf demselben Chip wie die CPU platziert sind und auf den Systemspeicher angewiesen sind, um Grafiken zu verarbeiten., wohingegen eine separate Grafikkarte eine von der CPU getrennte Einheit ist und eine hohe Grafikverarbeitungsleistung aufweist.

GPU-Fähigkeiten werden von separaten Grafikkarten bereitgestellt. Deswegen, Stellen Sie sicher, dass auf Ihrem Computer sowohl eine integrierte Grafikkarte als auch eine separate Grafikkarte installiert sind.

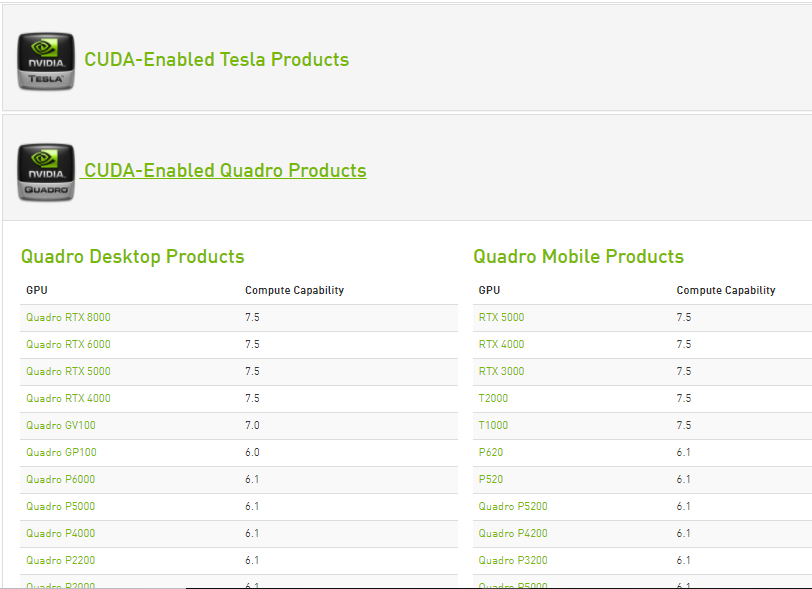

Die Rechenfähigkeiten jeder Cuda-fähigen Nvidia-Grafikkarte sind auf der Nvidia-Website aufgeführt. Nur wenn separate Grafikkarte in dieser Liste verfügbar ist, kann TensorFlow-GPU unterstützen.

Quelle: https://developer.nvidia.com/cuda-gpus

Sobald bekannt ist, dass die separate Grafikkarte die TensorFlow-GPU unterstützen kann. Beginnen Sie mit der Installation

Um sicherzustellen, dass sich keine der oben genannten NVidia-Einstellungen oder -Einstellungen auf die Installation auswirkt, Deinstallieren Sie alle NVidia-Software- und Grafiktreiber (optionaler Schritt).

Vorraussetzungen erforderlich

Paso 1: Visual Studio-Installation 2017

Microsoft Visual Studio ist eine integrierte Microsoft-Entwicklungsumgebung zur Entwicklung von Computerprogrammen, sowie Webseiten, Web Applikationen, Webdienste und mobile Anwendungen.

Das CUDA Toolkit enthält Visual Studio- und NSight IDE-Projektvorlagen (die Sie von Visual Studio verwenden können). Wir müssen das VC-Toolkit installieren ++ 2017 (CUDA ist noch nicht mit der neuesten Version von Visual Studio kompatibel).

- Visual Studio kann von der offiziellen Visual Studio-Website von Microsoft heruntergeladen werden. Laden Sie die Software herunter, indem Sie die Arbeitslast auswählen ‚Desktop-Entwicklung mit c ++‘ und installiere es.

- Cuda-Toolkit während der Installation, Installieren Sie die erforderlichen Bibliotheken und überprüfen Sie dann die auf dem System verfügbaren Versionen von Visual Studio und installieren Sie dann die Visual Studio-Integrationen. Deswegen, Die Installation von Visual Studio auf dem System ist ein obligatorischer Schritt.

Paso 2: Laden Sie den NVIDIA-Treiber herunter und installieren Sie ihn

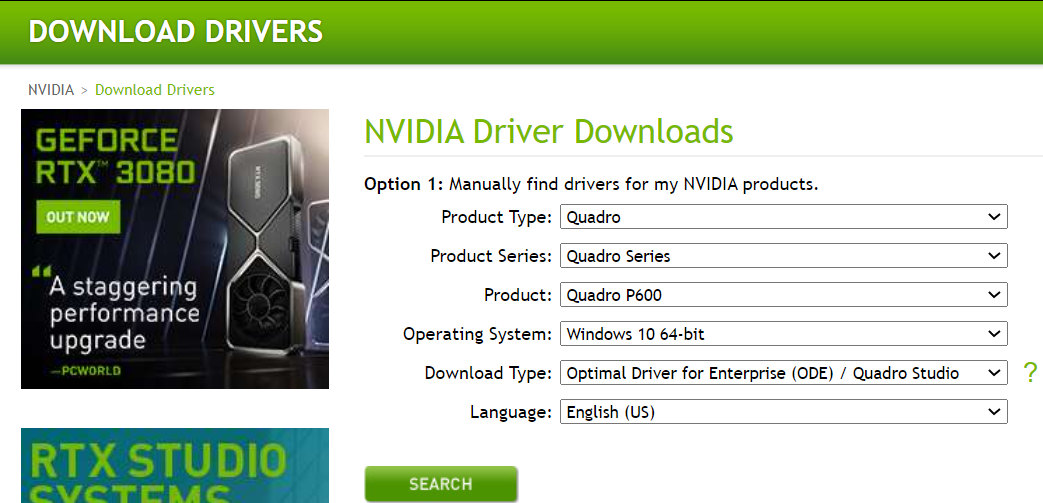

Nvidia-Treiber ist der Softwaretreiber für Nvidia Grafik-GPU auf dem PC installiert. Es ist ein Programm, das verwendet wird, um vom Windows-PC-Betriebssystem mit dem Gerät zu kommunizieren. Diese Software ist in den meisten Fällen erforderlich, damit das Hardwaregerät ordnungsgemäß funktioniert.

Herunterladen, Navigieren Sie zur Download-Seite von Nvidia.com und geben Sie alle Grafikkarten- und Systemdetails in den Dropdown-Menüs an. Klicken Sie auf Suche und wir stellen Ihnen den Download-Link zur Verfügung.

Installieren Sie die von Nvidia heruntergeladenen Treiber

einmal installiert, Wir sollten einen Ordner NVidia GPU Computing Toolkit in den Programmdateien von Laufwerk C erhalten, der den Unterordner CUDA enthält.

Paso 3: Cuda-Toolkit

Das Nvidia CUDA Toolkit bietet eine Entwicklungsumgebung zum Erstellen leistungsstarker GPU-beschleunigter Anwendungen. Mit dem CUDA-Toolkit, kann sich entwickeln, Optimieren und implementieren Sie Ihre Anwendungen auf GPU-beschleunigten eingebetteten Systemen, Desktop-Arbeitsplätze, Rechenzentren für Unternehmen, Cloud-basierte Plattformen und HPC-Supercomputer. Toolkit enthält GPU-beschleunigte Bibliotheken, Debugging- und Optimierungstools, ein C-Compiler / C ++ und eine Laufzeitbibliothek zum Erstellen und Bereitstellen Ihrer Anwendung auf allen wichtigen Architekturen, einschließlich x86, Arm y POWER.

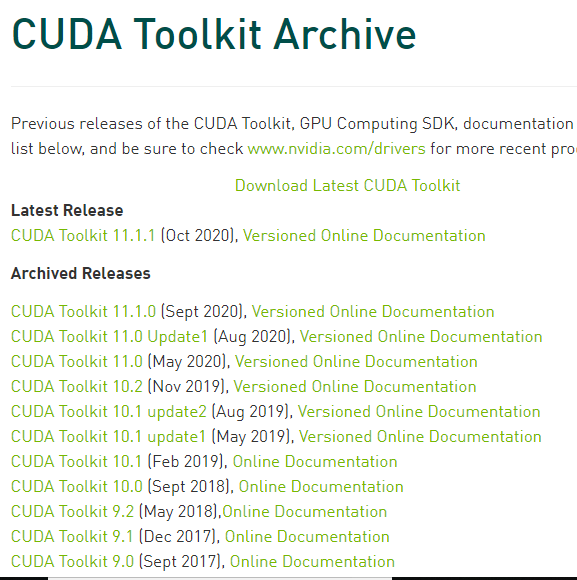

Es gibt mehrere Versionen von CUDA, die mit Tensorflow kompatibel sind. Wir finden die aktuelle Version von Cuda, die mit TensorFlow kompatibel ist, auf der TensorFlow GPU-Support-Webseite.

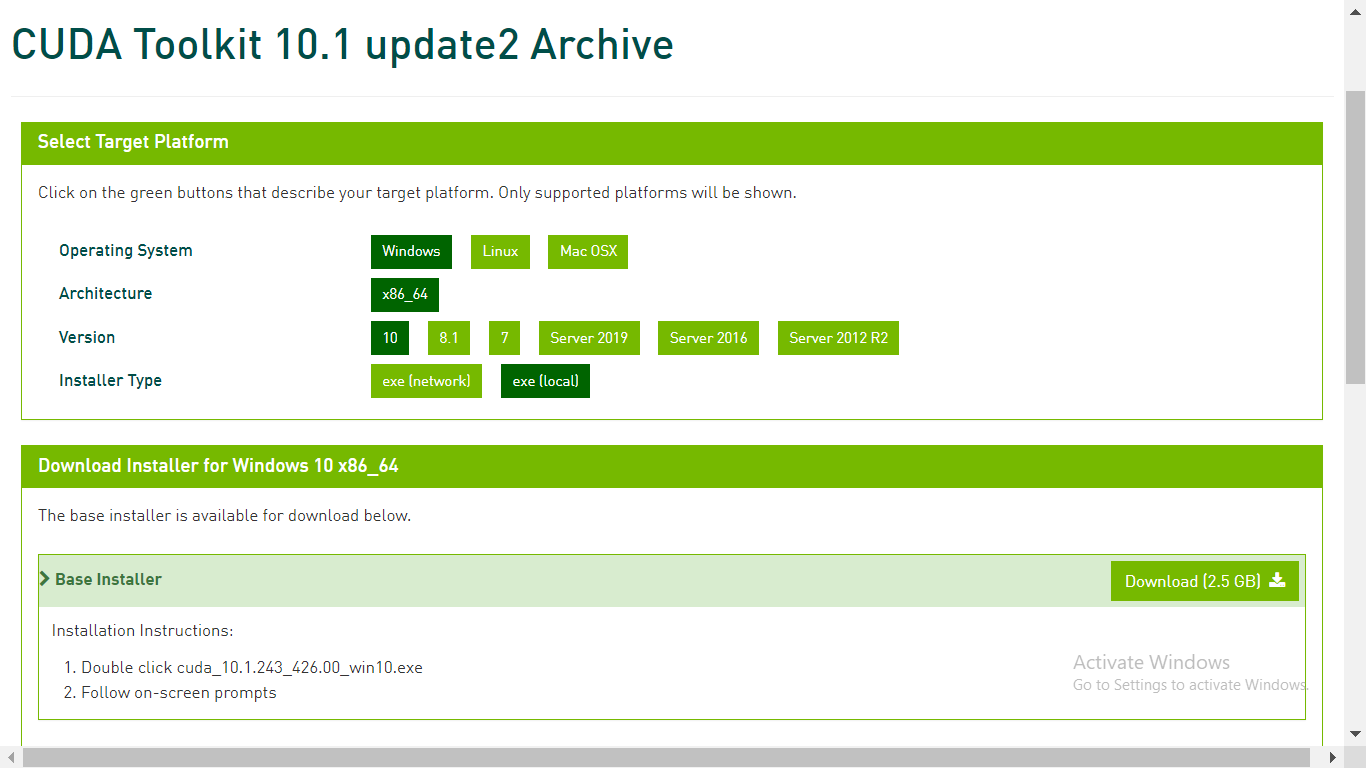

In der CUDA-Toolkit-Datei auf developer.nvidia.com, Laden Sie das erforderliche CUDA-Toolkit herunter

Paso 4: cuDNN herunterladen

cuDNN ist eine Bibliothek mit einer Reihe von optimierten Low-Level-Primitiven, um die Verarbeitungsgeschwindigkeit von tiefen neuronalen Netzen zu erhöhen (DNN) auf CUDA-kompatiblen GPUs.

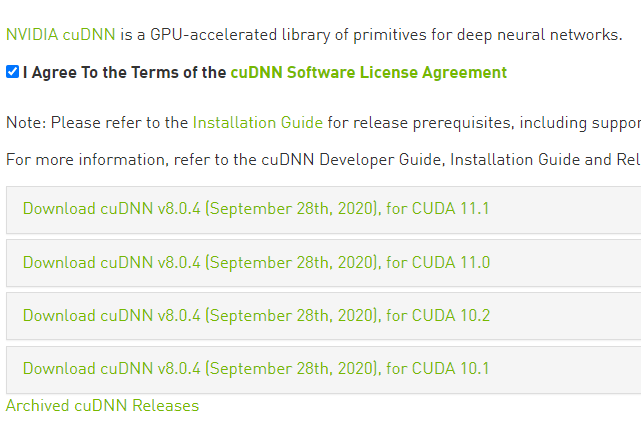

Gehen Sie zur cuDNN-Download-Webseite unter developer.nvidia.com und laden Sie die Version von cuDNN herunter, die mit der Version von CUDA kompatibel ist.

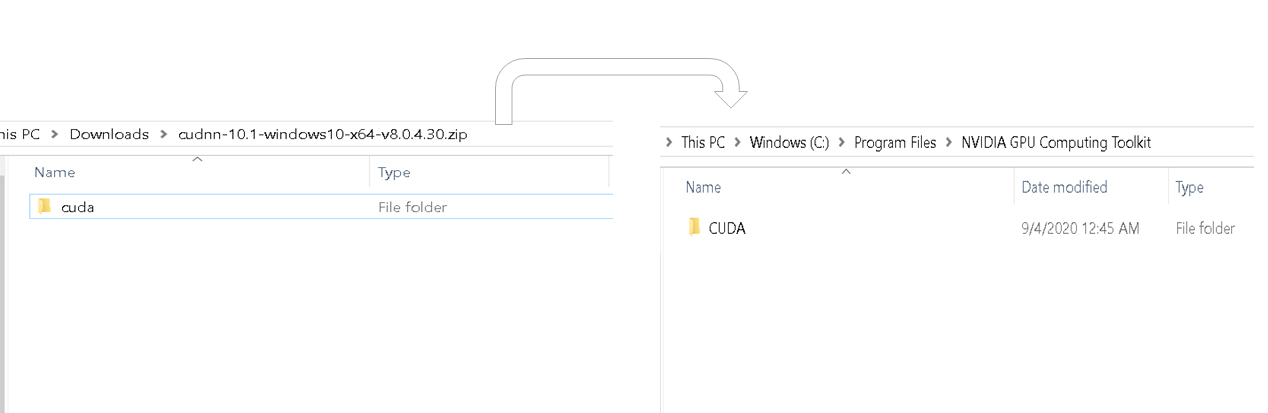

Sobald der Download abgeschlossen ist, entpacke den heruntergeladenen Ordner. Der heruntergeladene Ordner sollte den CUDA-Ordner enthalten und dieser CUDA-Ordner sollte inhaltlich mit dem CUDA-Ordner im NVidia GPU Calculation Toolkit Program Files-Ordner übereinstimmen. Bitte beachten Sie das Bild unten.

Kopieren Sie cudnn64_88.dll aus dem Bin des zuletzt extrahierten Ordners und fügen Sie es in den ähnlichen bin-Ordner im Cuda-Ordner des Nvidia GPU Computing Toolkit ein.

Kopieren Sie die Datei cudnn.h aus dem include-Unterordner des zuletzt extrahierten Ordners und fügen Sie sie in den ähnlichen bin-Ordner im Cuda-Ordner des Nvidia GPU Computing Toolkits ein.

Kopieren Sie die Datei cudnn.lib von lib> X64-Ordner-Unterordner des zuletzt extrahierten Ordners und fügen Sie ihn in den ähnlichen bin-Ordner im Cuda-Ordner des Nvidia GPU Computing Toolkit ein.

Jetzt haben wir den Download und die Installation von Cuda für GPU abgeschlossen. Lass uns die Umgebung einrichten.

Einrichtung und Konfiguration der GPU-Umgebung

Anaconda ist eine Python-Distribution, die beim Einrichten einer virtuellen Umgebung hilft. Vorausgesetzt, Anaconda ist bereits installiert, Beginnen wir mit der Erstellung einer virtuellen Umgebung.

Paso 1: CreEr aß einen VariableIn Statistik und Mathematik, ein "Variable" ist ein Symbol, das einen Wert darstellt, der sich ändern oder variieren kann. Es gibt verschiedene Arten von Variablen, und qualitativ, die nicht-numerische Eigenschaften beschreiben, und quantitative, numerische Größen darstellen. Variablen sind grundlegend in Experimenten und Studien, da sie die Analyse von Beziehungen und Mustern zwischen verschiedenen Elementen ermöglichen, das Verständnis komplexer Phänomene zu erleichtern.... der Umwelt

Erstellen Sie eine virtuelle Umgebung über die Eingabeaufforderung mit dem Befehl – conda erstellen -n [Umgebungsname] Python = [python_version]

Tensor Flow unterstützt nur einige Versionen von Python. Wählen Sie eine Version von Python aus, die unterstützt TensorTensoren sind mathematische Strukturen, die Konzepte wie Skalare und Vektoren verallgemeinern. Sie werden in verschiedenen Disziplinen eingesetzt, einschließlich Physik, Ingenieurwesen und maschinelles Lernen, um mehrdimensionale Daten darzustellen. Ein Tensor kann als mehrdimensionale Matrix visualisiert werden, , die es ermöglicht, komplexe Beziehungen zwischen verschiedenen Variablen zu modellieren. Ihre Vielseitigkeit und Fähigkeit, große Informationsmengen zu verarbeiten, machen sie zu grundlegenden Werkzeugen in der Datenanalyse und -verarbeitung.... beim Erstellen einer Umgebung.

Dann, Aktivieren Sie die virtuelle Umgebung mit dem Befehl – aktivieren Sie [Umgebungsname].

Innerhalb der erstellten virtuellen Umgebung, Installieren Sie die neueste Version der Tensor-Flow-GPU mit dem Befehl – pip installieren – Ignorieren-installiert –Upgrade TensorFlow-GPU

Sobald wir mit der Tensor-Flow-GPU-Installation fertig sind, Überprüfen Sie, ob Ihr Computer über grundlegende Python-Pakete wie Pandas verfügt, numpy, Jupyter und Hard. wenn sie nicht existieren, installiere sie.

Installieren Sie ipykernel per Befehl – pip installiere ipykernel

Lassen Sie uns den Anzeigenamen festlegen und den Kernel mit dem Befehl an die Variable der virtuellen Umgebung binden – python –m ipykernel install –user –name [Umgebungsname] –Anzeigename "beliebiger Name".

Paso 2: setze Python-Kernel auf Jupyter.

Öffnen Sie das Jupyter-Notebook und klicken Sie in der Menüleiste auf Kernel und ändern Sie den Kernel in die Umgebungsvariable, die wir gerade festgelegt haben

Testen und überprüfen Sie die GPU-Installation.

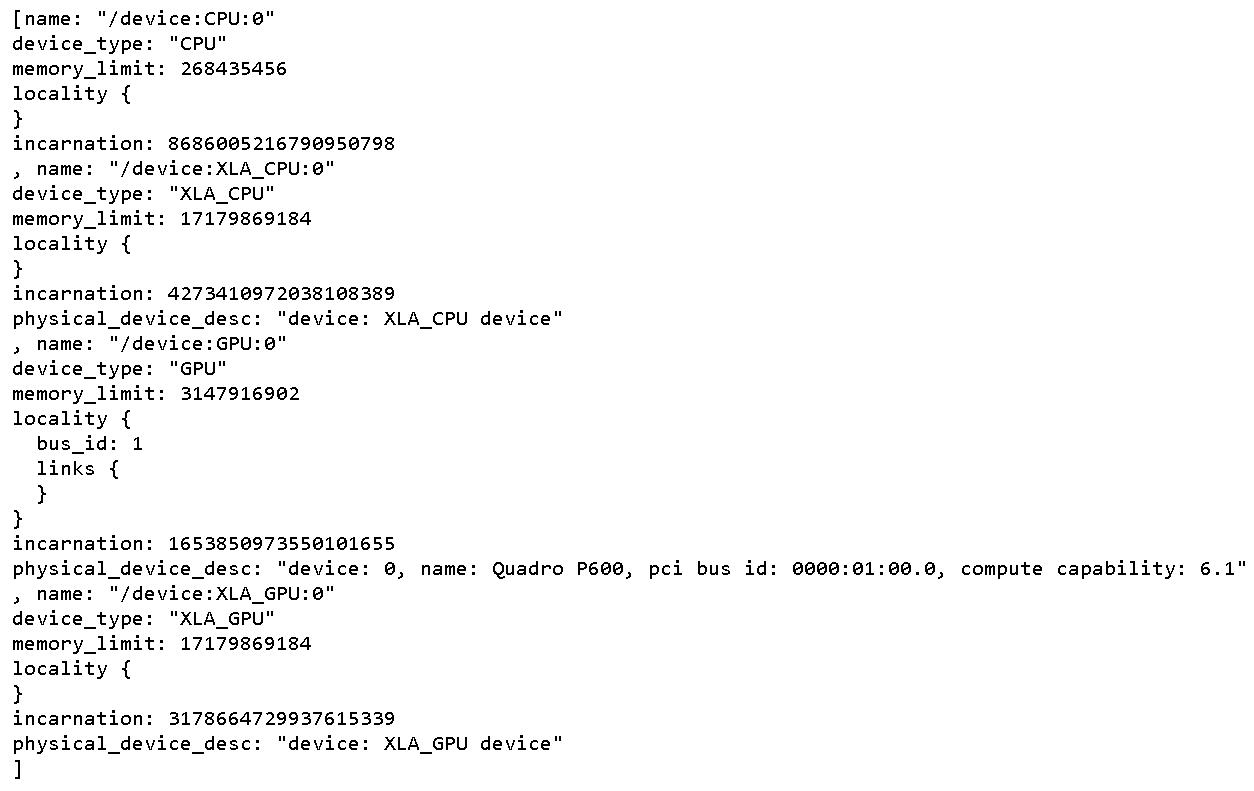

Um alles zu überprüfen körperlich GPU-Geräte verfügbar für TensorFlow. Führen Sie den folgenden Code aus

From tensorflow.python.client import device_lib

print(device_lib.list_local_devices())

Dadurch werden alle für Tensorflow verfügbaren Geräte gedruckt

So überprüfen Sie, ob CUDA für TensorFlow aktiviert ist, führe den folgenden Code aus

Import tensorflow as tf

print(tf.test.is_built_with_cuda())

Die Ausgabe ist ein boolescher Wert, der true zurückgibt, wenn TensorFlow mit CUDA kompiliert ist

Um herauszufinden, ob die GPU während der Laufzeit aufwacht, Starten Sie die Ausführung eines beliebigen rotes neuronalesNeuronale Netze sind Rechenmodelle, die von der Funktionsweise des menschlichen Gehirns inspiriert sind. Sie nutzen Strukturen, die als künstliche Neuronen bekannt sind, um Daten zu verarbeiten und daraus zu lernen. Diese Netze sind grundlegend im Bereich der künstlichen Intelligenz, Dies ermöglicht erhebliche Fortschritte bei Aufgaben wie der Bilderkennung, Verarbeitung natürlicher Sprache und Vorhersage von Zeitreihen, unter anderen. Ihre Fähigkeit, komplexe Muster zu erlernen, macht sie zu mächtigen Werkzeugen.. Komplex.

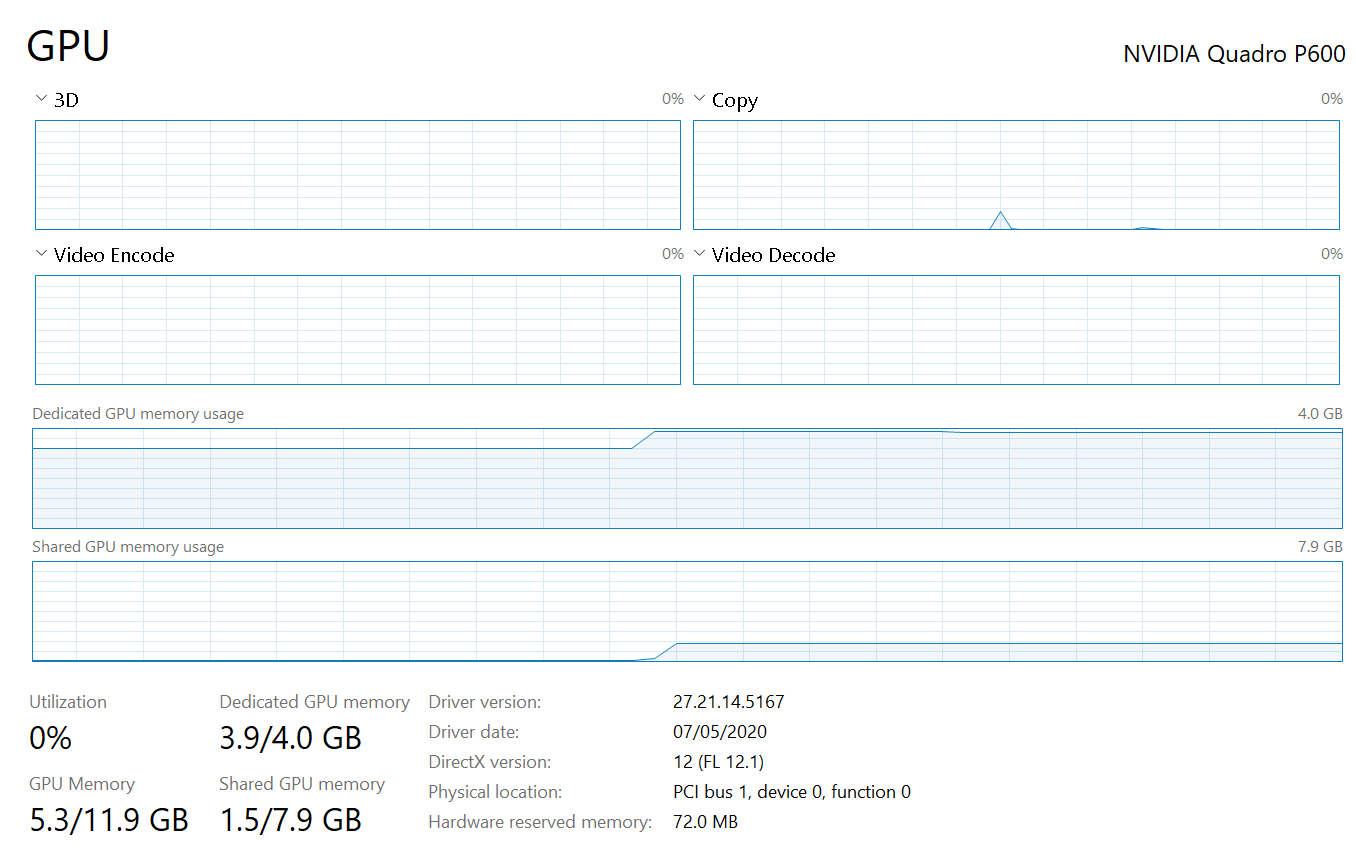

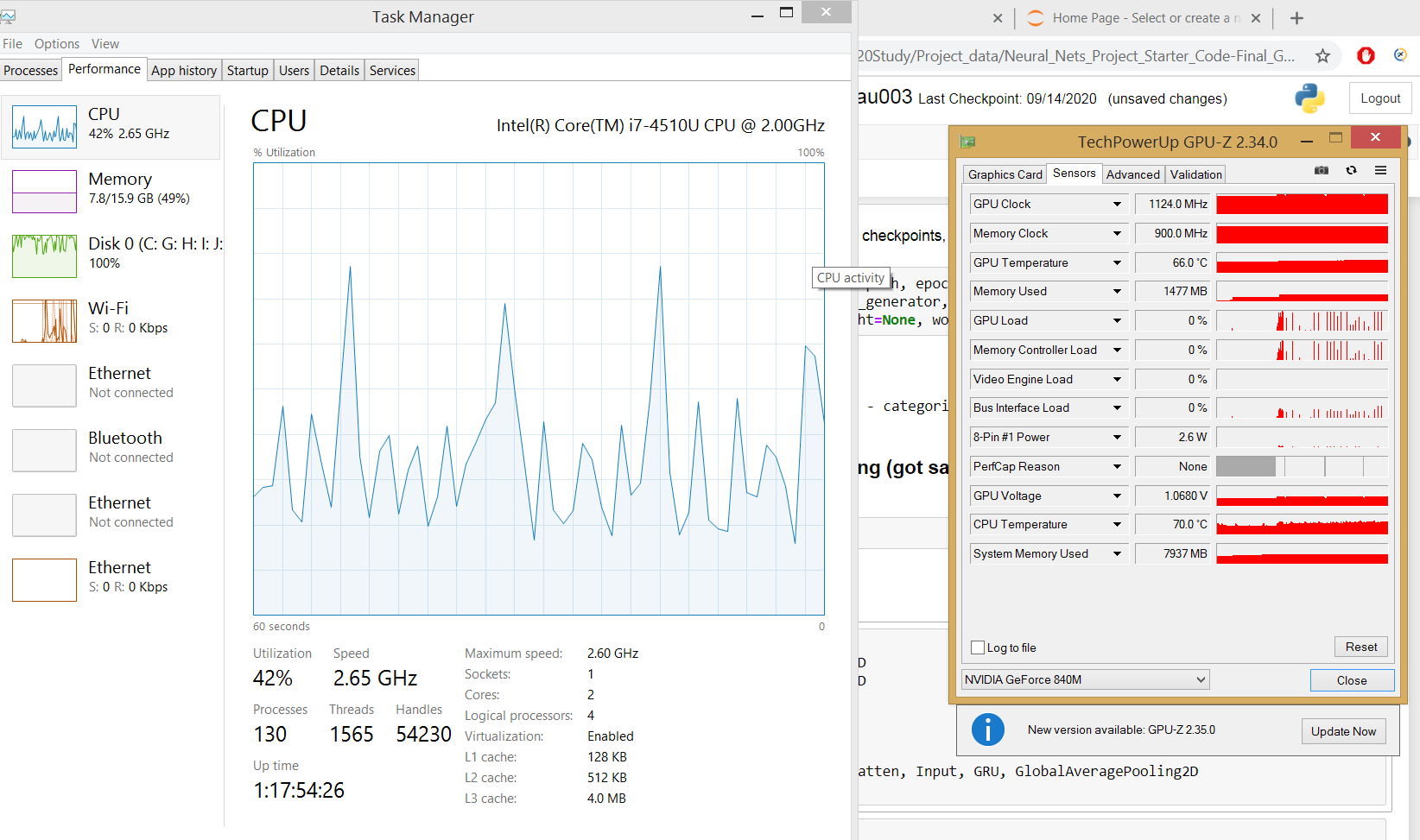

Der Taskmanager zeigt die Auslastung der GPU und den belegten Speicher für die Ausführung des Tensorflow-Programms an.

wenn der Prozess-Tab des Task-Managers keine GPU-Auslastung anzeigt, Dies ist ein Szenario für Maschinen, die auf dem Windows-Betriebssystem ausgeführt werden 8.1, Verwenden Sie Tools von Drittanbietern wie GPUZ, um die GPU-Auslastung zu beobachten

Jetzt ist die komplette GPU Installation und Konfiguration abgeschlossen.

Fazit

-

- Es gibt viele kostenlose GPU-Cloud-Computing-Plattformen, die unsere GPU-Berechnungen in tiefen neuronalen Netzen beschleunigen könnten. Probieren Sie sie also aus, wenn Ihr Computer keine dedizierte GPU enthält.

- Alle oben genannten Installationsschritte hängen voneinander ab, also müssen wir die gleiche Reihenfolge wie oben beschrieben befolgen.

- Es gibt keine Möglichkeit, zu debuggen, warum unser Computer keine dedizierte GPU verbrauchen kann, also verpasse keinen der schritte.