Este artigo foi publicado como parte do Data Science Blogathon.

Visão geral

- comprender las GPU en aprendizado profundoAqui está o caminho de aprendizado para dominar o aprendizado profundo em, Uma subdisciplina da inteligência artificial, depende de redes neurais artificiais para analisar e processar grandes volumes de dados. Essa técnica permite que as máquinas aprendam padrões e executem tarefas complexas, como reconhecimento de fala e visão computacional. Sua capacidade de melhorar continuamente à medida que mais dados são fornecidos a ele o torna uma ferramenta fundamental em vários setores, da saúde....

- Começando com os pré-requisitos para instalar o TensorFlow -GPU.

- Instalação e configuração do ambiente de GPU.

- Testando e verificando a instalação da GPU

“Os gráficos fizeram

uma grande mudança em direção ao aprendizado de máquina, que em si é sobre a compreensão

dados”

_ Jefferson Han, fundador e cientista-chefe da Perceptive Pixel

Fonte: Imagens do google

Compreenda as GPUs no aprendizado profundo

CPUs podem recuperar dados em um ritmo mais rápido, mas eles não podem processar mais dados ao mesmo tempo, uma vez que a CPU tem que fazer muitas iterações na memória principal para realizar uma tarefa simples. Por outro lado, a GPU vem com sua própria memória VRAM (RAM de vídeo) dedicada, portanto, faz menos chamadas para a memória principal, então é rápido

A CPU executa tarefas sequencialmente e tem menos núcleos, mas as GPUs vêm com centenas de núcleos menores que funcionam em paralelo, o que torna a GPU uma arquitetura altamente paralela, o que melhora o desempenho.

Começando com os pré-requisitos para instalar o TensorFlow – GPU

A GPU Tensorflow só funciona se você tiver uma placa gráfica habilitada para CUDA. Todas as placas de vídeo NVidia mais recentes dos últimos três a quatro anos habilitaram CUDA.

Porém, vamos fazer uma pausa e verificar se sua placa gráfica está habilitada para CUDA, uma vez que "Fazer suposições incorretas causa dor e sofrimento para todos", dijo jennifer jovem.

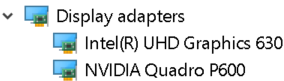

Para verificar os detalhes da placa gráfica. Abra a janela de execução no menu Iniciar e execute o Controle / nome Microsoft.DeviceManager. A placa gráfica aparecerá em Adaptadores de vídeo

Cada máquina será equipada com placas gráficas integradas que são colocadas no mesmo chip da CPU e contam com a memória do sistema para lidar com os gráficos., Considerando que uma placa gráfica discreta é uma unidade separada da CPU e tem alto desempenho de processamento gráfico.

Os recursos de GPU são fornecidos por placas gráficas discretas. Portanto, certifique-se de que sua máquina possui gráficos integrados e placas gráficas discretas instaladas.

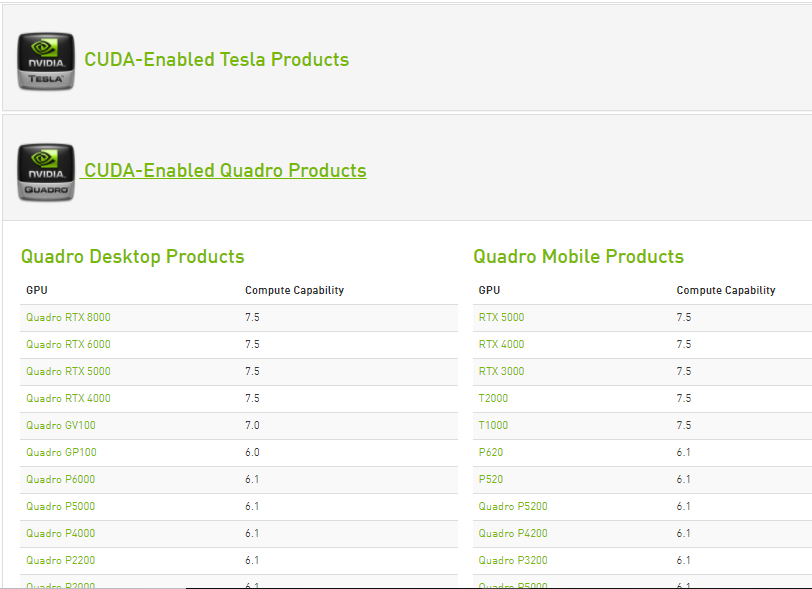

Os recursos de computação de cada placa de vídeo Nvidia habilitada para Cuda estão listados no site da Nvidia. Somente se a placa de vídeo discreta estiver disponível nesta lista, pode ser compatível com a GPU TensorFlow.

Fonte: https://developer.nvidia.com/cuda-gpus

Uma vez que se sabe que a placa gráfica discreta pode suportar a GPU TensorFlow. Comece com a instalação

Para garantir que nenhuma das configurações ou configurações NVidia acima não afetem a instalação, desinstale todos os drivers de software e gráficos NVidia (passo opcional).

Instalações de pré-requisito necessárias

Paso 1: Instalação do Visual Studio 2017

Microsoft Visual Studio é um ambiente de desenvolvimento integrado da Microsoft usado para desenvolver programas de computador, bem como sites, Aplicativos da web, serviços da web e aplicativos móveis.

O CUDA Toolkit inclui modelos de projeto do Visual Studio e NSight IDE (que você pode usar no Visual Studio). Precisamos instalar o kit de ferramentas VC ++ 2017 (CUDA ainda não é compatível com a versão mais recente do Visual Studio).

- O Visual Studio pode ser baixado do site oficial do Visual Studio da Microsoft. Baixe o software selecionando a carga de trabalho ‘Desenvolvimento de desktop com c ++’ e instale-o.

- Kit de ferramentas Cuda durante a instalação, instale as bibliotecas necessárias e, em seguida, verifique as versões do Visual Studio disponíveis no sistema e instale as integrações do Visual Studio. Portanto, ter um Visual Studio instalado no sistema é uma etapa obrigatória a seguir.

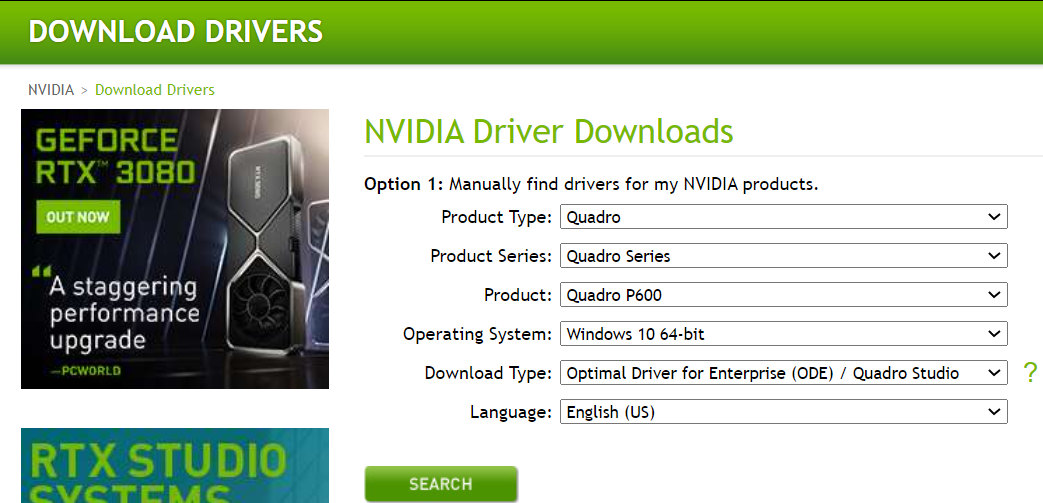

Paso 2: Baixe e instale o driver NVIDIA

Driver nvidia é o driver de software para Nvidia GPU gráfica instalada no PC. É um programa usado para se comunicar do sistema operacional Windows PC para o dispositivo. Este software é necessário na maioria dos casos para que o dispositivo de hardware funcione corretamente.

Para descarregar, Navegue até a página de download do Nvidia.com e forneça todos os detalhes da placa gráfica e do sistema nos menus suspensos. Clique em pesquisar e forneceremos o link de download.

Instale os drivers baixados da Nvidia

uma vez instalado, devemos obter uma pasta NVidia GPU computing toolkit nos arquivos de programa da unidade C que contém a subpasta CUDA dentro.

Paso 3: Cuda Toolkit

O kit de ferramentas Nvidia CUDA fornece um ambiente de desenvolvimento para a criação de aplicativos acelerados por GPU de alto desempenho. Com o kit de ferramentas CUDA, pode desenvolver, otimizar e implantar seus aplicativos em sistemas incorporados acelerados por GPU, estações de trabalho desktop, data centers corporativos, plataformas baseadas em nuvem e supercomputadores HPC. O kit de ferramentas inclui bibliotecas aceleradas por GPU, ferramentas de depuração e otimização, um compilador C / C ++ e uma biblioteca de tempo de execução para construir e implantar seu aplicativo em todas as principais arquiteturas, incluindo x86, Arm y POWER.

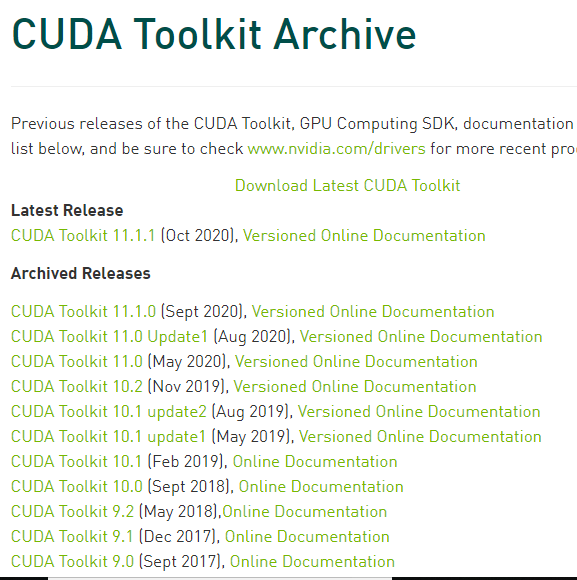

Existem várias versões do CUDA que são compatíveis com o Tensorflow. Podemos encontrar a versão atual do Cuda compatível com TensorFlow, na página de suporte de GPU do TensorFlow.

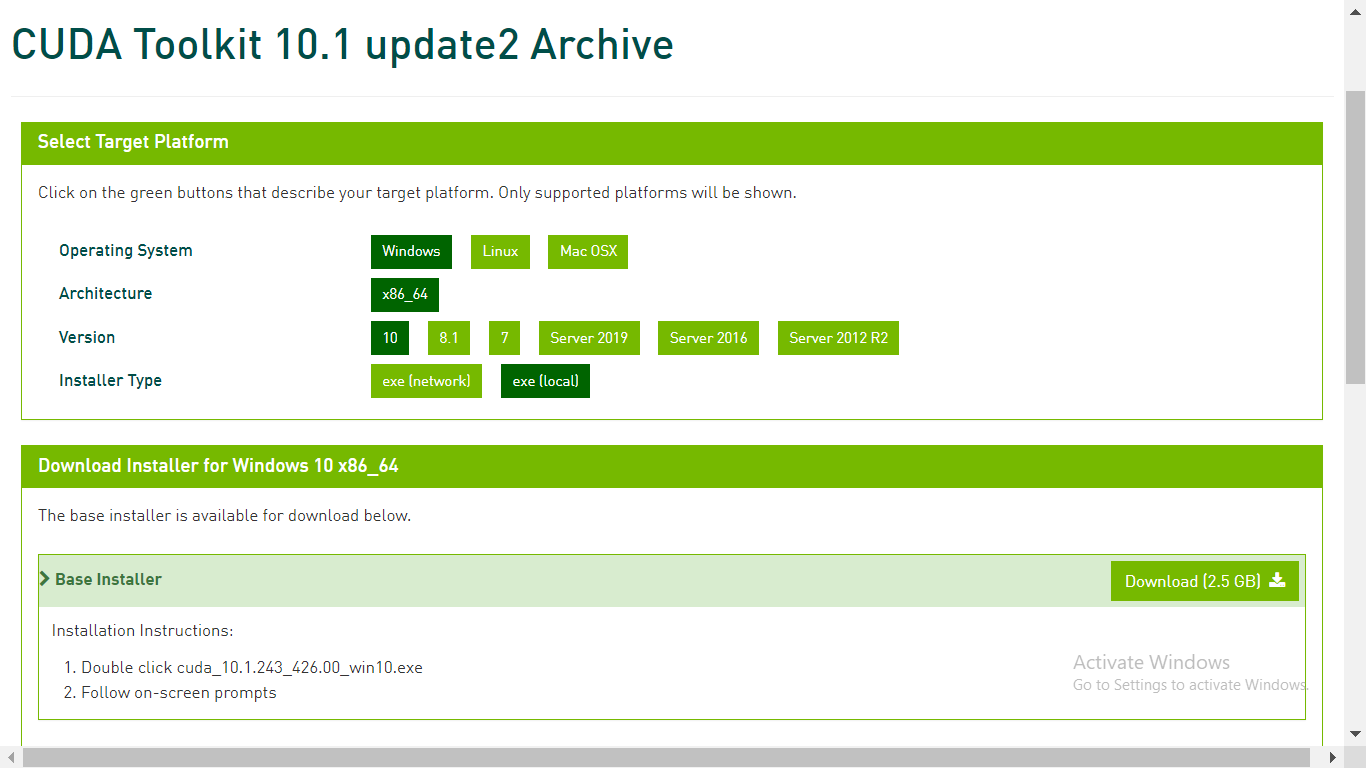

No arquivo do kit de ferramentas CUDA em developer.nvidia.com, baixe o kit de ferramentas CUDA necessário

Paso 4: Baixar cuDNN

cuDNN é uma biblioteca com um conjunto de primitivas otimizadas de baixo nível para aumentar a velocidade de processamento de redes neurais profundas (DNN) em GPUs compatíveis com CUDA.

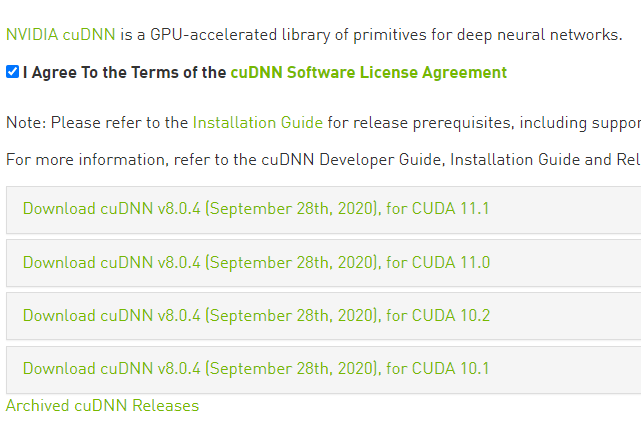

Vá para a página web de download developer.nvidia.com cuDNN e baixe a versão CUDA da versão cuDNN.

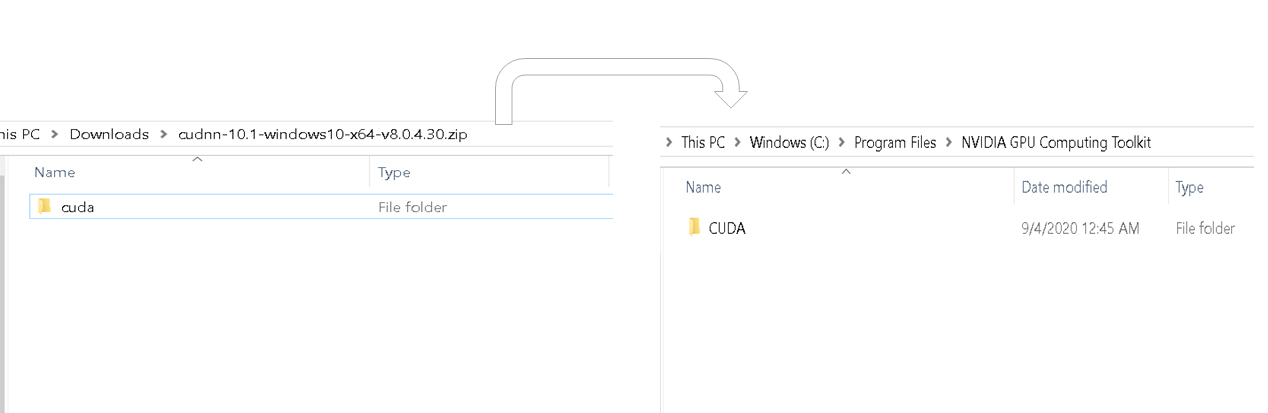

Assim que o download for concluído, extrair a pasta baixada. a pasta baixada deve conter a pasta cuda e esta pasta cuda deve corresponder ao conteúdo da pasta cuda na pasta de arquivos do programa do kit de ferramentas de cálculo da Nvidia GPU. Veja a imagem abaixo.

copiar cudnn64_88.dll da lixeira da última pasta extraída e colá-la na pasta de lixo semelhante dentro da pasta de cuda do kit de ferramentas de computação nvidia gpu.

Copie o arquivo cudnn.h da subpasta de inclusão da última pasta extraída e cole-o na pasta bin semelhante dentro da pasta Cuda do kit de ferramentas de computação GPU da Nvidia.

Copie o arquivo cudnn.lib da lib> X64 pasta subpasta da última pasta extraída e cole-a na pasta bin semelhante dentro da pasta Cuda do Nvidia GPU Computing Toolkit.

Agora concluímos o download e a instalação do Cuda para GPU. Vamos configurar o ambiente.

Instalação e configuração do ambiente de GPU

Anaconda é uma distribuição Python que ajuda a configurar um ambiente virtual. Assumindo que o anaconda já está instalado, vamos começar criando um ambiente virtual.

Paso 1: Crecomió una variávelEm estatística e matemática, uma "variável" é um símbolo que representa um valor que pode mudar ou variar. Existem diferentes tipos de variáveis, e qualitativo, que descrevem características não numéricas, e quantitativo, representando quantidades numéricas. Variáveis são fundamentais em experimentos e estudos, uma vez que permitem a análise de relações e padrões entre diferentes elementos, facilitando a compreensão de fenômenos complexos.... de meio ambiente

Crie um ambiente virtual a partir do prompt de comando usando o comando – conda criar -n [env_name] python = [python_version]

O fluxo do tensor é compatível apenas com algumas versões do Python. Elija una versión de Python que admita tensorLos tensores son estructuras matemáticas que generalizan conceptos como scalars y vectores. Se utilizan en diversas disciplinas, incluyendo física, ingeniería y aprendizaje automático, para representar datos multidimensionales. Un tensor puede ser visualizado como una matriz de múltiples dimensiones, lo que permite modelar relaciones complejas entre diferentes variables. Su versatilidad y capacidad para manejar grandes volúmenes de información los convierten en herramientas fundamentales en el análisis y procesamiento de datos.... mientras crea un entorno.

A seguir, ative o ambiente virtual usando o comando – Ativar [env_name].

Dentro do ambiente virtual criado, instale a versão mais recente do tensor flow GPU usando o comando – pip install – ignore-installed –upgrade TensorFlow-GPU

Assim que terminarmos com a instalação da GPU de fluxo tensor, verifique se sua máquina tem pacotes básicos de python como pandas, entorpecido, Jupyter y Hard. se eles não existem, instale-os.

Instale o ipykernel via comando – pip install ipykernel

Vamos definir o nome de exibição e vincular o kernel à variável de ambiente virtual usando o comando – python –m ipykernel install –user –name [env_name] –Display-name "qualquer nome".

Paso 2: definir kernel python para jupyter.

Abra o notebook jupyter e, na barra de menus, clique em kernel e mude o kernel para a variável de ambiente que acabamos de definir

Teste e verifique a instalação da GPU.

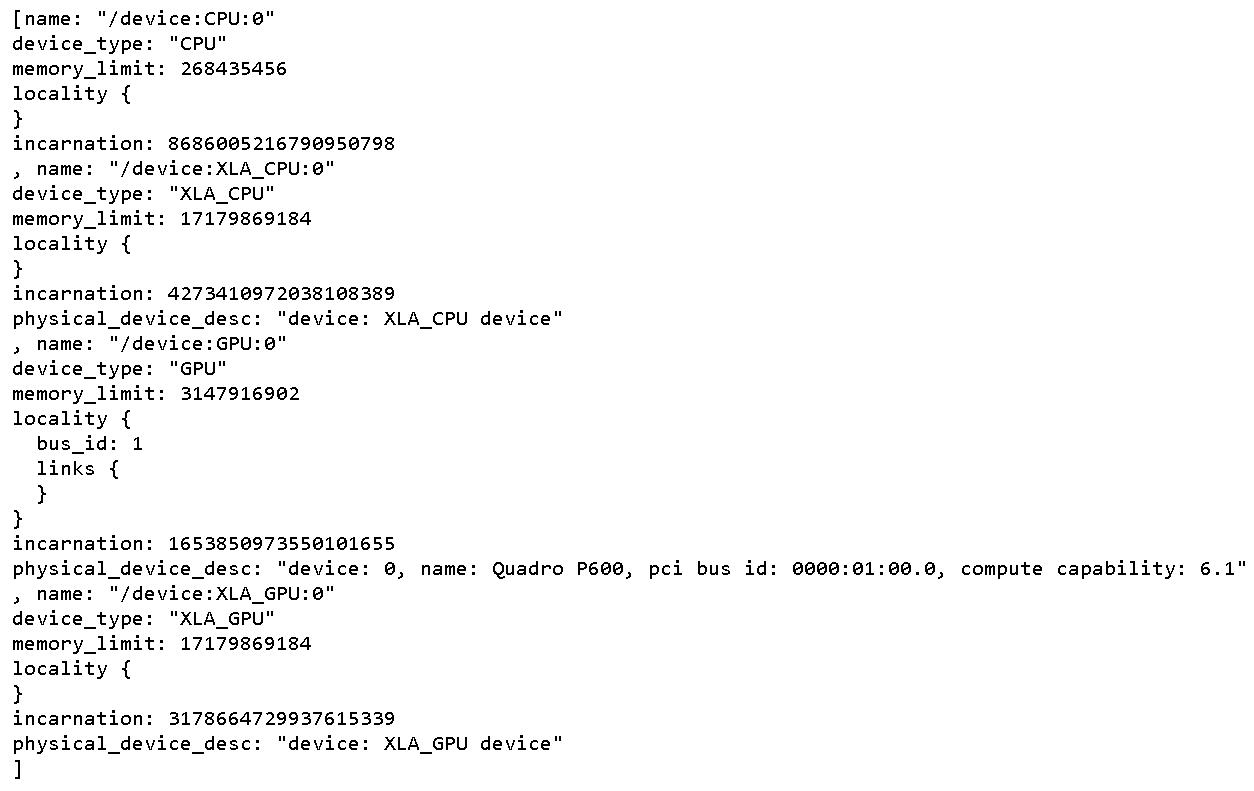

Para verificar tudo fisica Dispositivos GPU disponível para TensorFlow. Execute o seguinte código

From tensorflow.python.client import device_lib

print(device_lib.list_local_devices())

Isso imprime todos os dispositivos disponíveis para Tensorflow

Para verificar si CUDA está habilitado para TensorFlow, execute o seguinte código

Import tensorflow as tf

print(tf.test.is_built_with_cuda())

A saída será um valor booleano que retorna verdadeiro se o TensorFlow for compilado com CUDA

Para descobrir se a GPU acorda durante o tempo de execução, inicie la ejecución de cualquier neuronal vermelhoAs redes neurais são modelos computacionais inspirados no funcionamento do cérebro humano. Eles usam estruturas conhecidas como neurônios artificiais para processar e aprender com os dados. Essas redes são fundamentais no campo da inteligência artificial, permitindo avanços significativos em tarefas como reconhecimento de imagem, Processamento de linguagem natural e previsão de séries temporais, entre outros. Sua capacidade de aprender padrões complexos os torna ferramentas poderosas.. compleja.

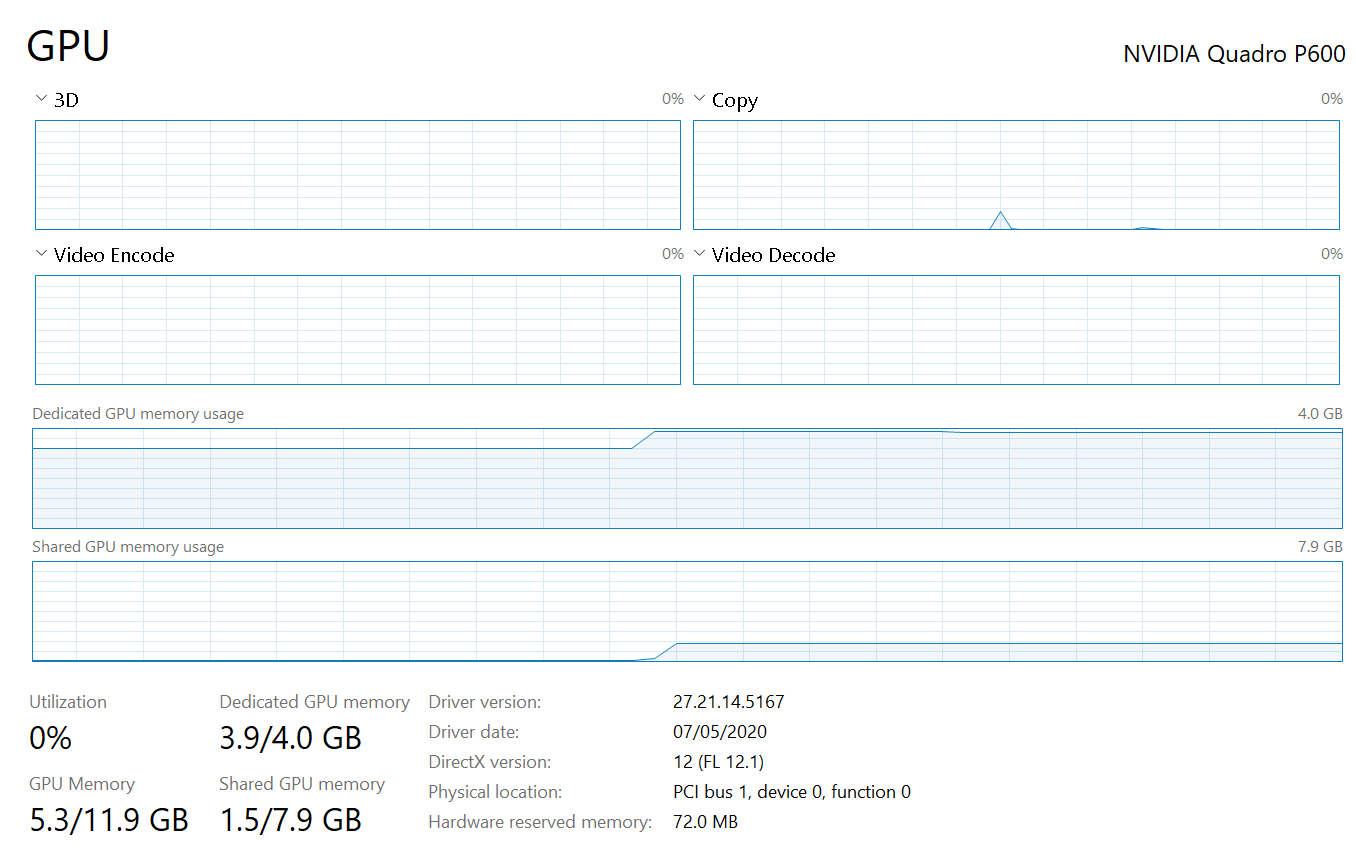

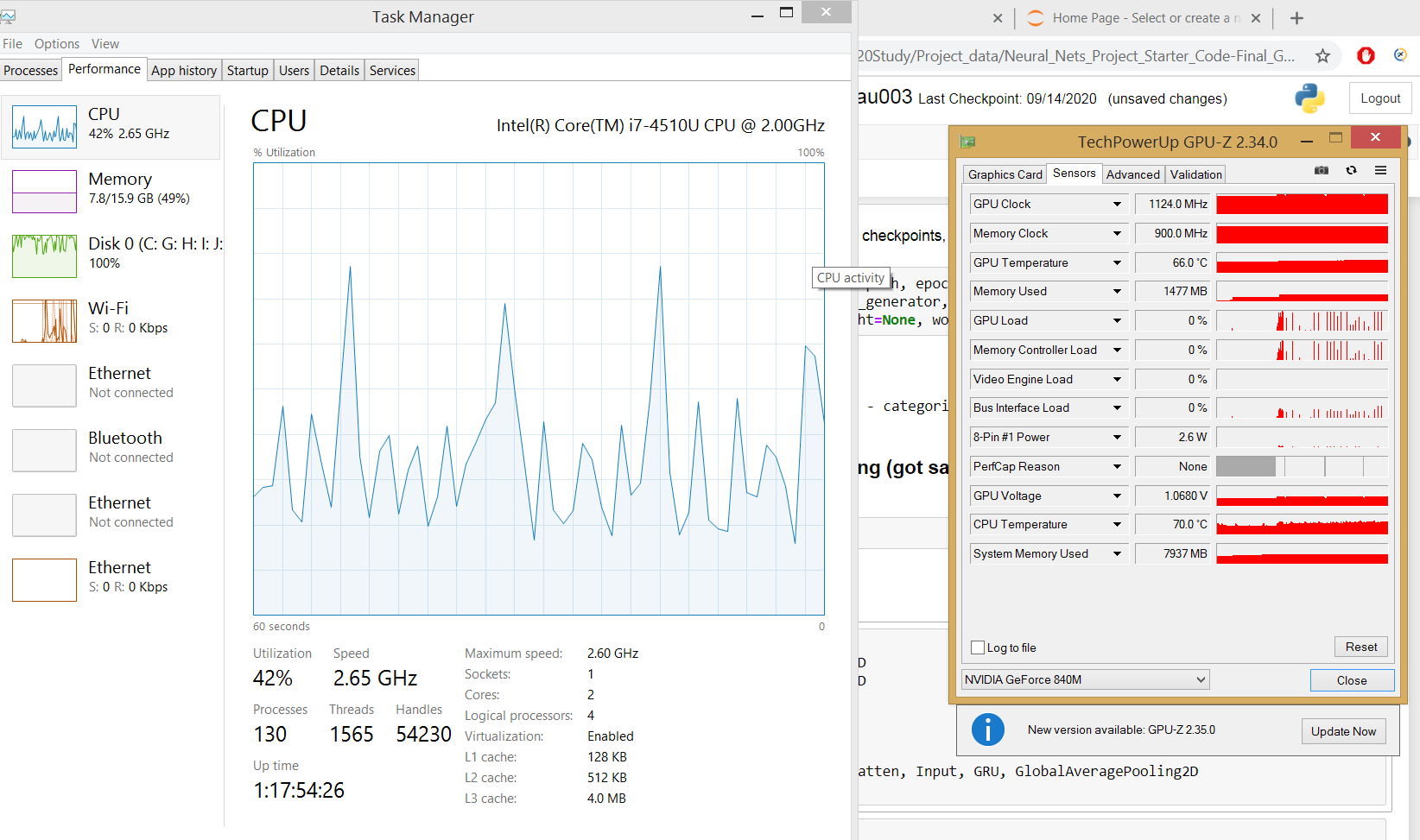

O gerenciador de tarefas mostra a utilização da GPU e a memória ocupada para a execução do programa Tensorflow.

se a guia de processo do gerenciador de tarefas não mostra a utilização da GPU, que é um cenário para máquinas rodando no sistema operacional Windows 8.1, use ferramentas de terceiros como GPUZ para observar a utilização da GPU

Agora, a instalação e configuração completas da GPU estão concluídas.

conclusão

-

- Existem muitas plataformas de computação em nuvem de GPU gratuitas que podem acelerar nossos cálculos de GPU em redes neurais profundas. Então experimente se sua máquina não contiver uma GPU dedicada.

- Todas as etapas de instalação acima dependem umas das outras, então devemos seguir a mesma sequência mencionada acima.

- Não há como depurar por que nossa máquina não pode consumir GPU dedicada, então não perca nenhuma das etapas.